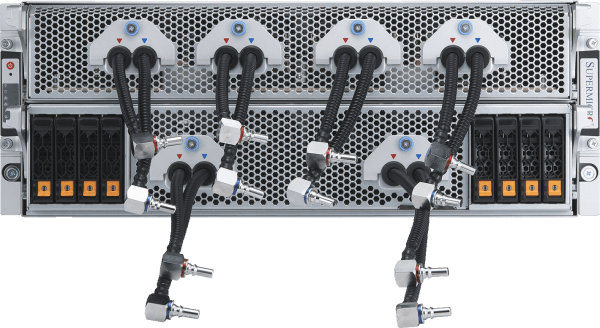

領先的液冷式AI叢集

配備 32 台 NVIDIA HGX H100/H200 8-GPU、4U 液冷系統(共 256 顆 GPU),分佈於 5 個機架中

- 透過Supermicro客製化液冷解決方案,將運算密度提升一倍,同時為資料中心節省高達40%的電力成本

- 單一可擴展單元內含256顆NVIDIA H100/H200 GPU

- 單一可擴展單元內配備20TB HBM3記憶體搭配H100,或36TB HBM3e記憶體搭配H200

- 每顆GPU皆配備1:1網路連接,啟用NVIDIA GPUDirect RDMA與儲存功能,用於訓練參數規模高達數兆的大型語言模型

- 可客製化的AI資料管道儲存結構,提供業界領先的平行式檔案系統配置

- 支援 NVIDIA Quantum-2 InfiniBand 與 Spectrum-X 以太網路平台

- 通過NVIDIA AI Enterprise平台認證,包括NVIDIA NIM微服務

運算節點

精選資源