在現今的AI時代,衡量算力的單位不再僅基於伺服器的數量。經互連的GPU、CPU、記憶體、儲存,以及這些機架內多個節點的運算資源,為目前的AI技術奠定了基礎。運算基礎設施需要高速且低延遲的網路結構,以及經精密設計的冷卻技術和電力供應,以維持每個資料中心環境的最佳效能和效率。Supermicro的SuperCluster解決方案可為正快速進步的生成式AI和大型語言模型(LLM)提供端對端AI資料中心解決方案。

大規模完整整合

設計與建造完整的機架與叢集系統,具備高達全球製造產能 5,000 機架 每月

測試、驗證、部署與現場服務

經過驗證的L11、L12測試流程在出貨前徹底驗證了操作效能與效率

液冷/風冷

包括GPU與CPU冷板、冷卻液分配單元與歧管的完善整合式液冷或氣冷解決方案

供應與庫存管理

一站式服務,快速準時交付完全整合的機架,縮短解決方案部署時間,實現快速部署

完整的交鑰匙數據中心解決方案,能加速關鍵任務型企業應用場景的交付週期,並消除建置大型叢集的複雜性——此類叢集過去僅能透過超級運算的密集設計調校與耗時優化方能實現。

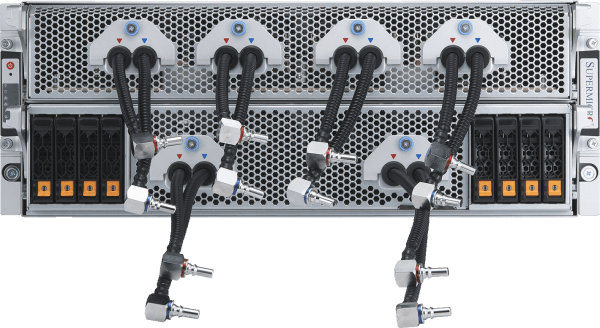

液冷式雙機箱 NVIDIA HGX B300AI

完全整合式液冷144節點叢集,配備高達1152顆NVIDIA B300 GPU

- NVIDIA HGX B300 憑藉緊湊型 2-OU 液冷系統節點,實現無可匹敵的AI 效能密度

- Supermicro 1.8MW 容量的機櫃內冷卻單元(亦提供機架內冷卻單元選項)

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 採用 NVIDIAQuantum-X800InfiniBand 實現橫向擴展,打造ultra、高頻寬AI

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

液冷式4U NVIDIA HGX B300AI

完全整合的液冷式72節點叢集,配備多達576顆NVIDIA B300 GPU

- 部署高效能AI 與推論,採用針對運算密度與可維護性優化的 NVIDIA HGX B300

- Supermicro 液冷技術專為持續高功率運作設計,並提升能源效率

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 透過 NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-X800InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

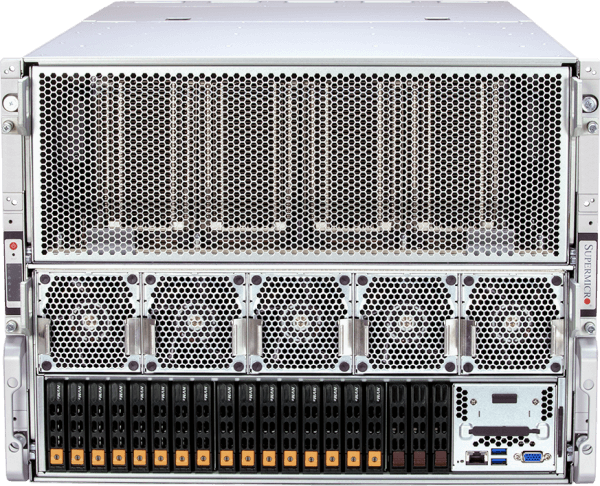

風冷式 8U NVIDIA HGX B300AI

完全整合的風冷式72節點叢集,配備多達576張NVIDIA B300 GPU

- 採用NVIDIA HGX B300實現可擴展AI 推論部署,其風冷設計可提升資料中心的廣泛相容性

- 優化的氣流與散熱設計,實現無需液冷基礎設施即可達成的高效能運作

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 透過 NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-X800InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

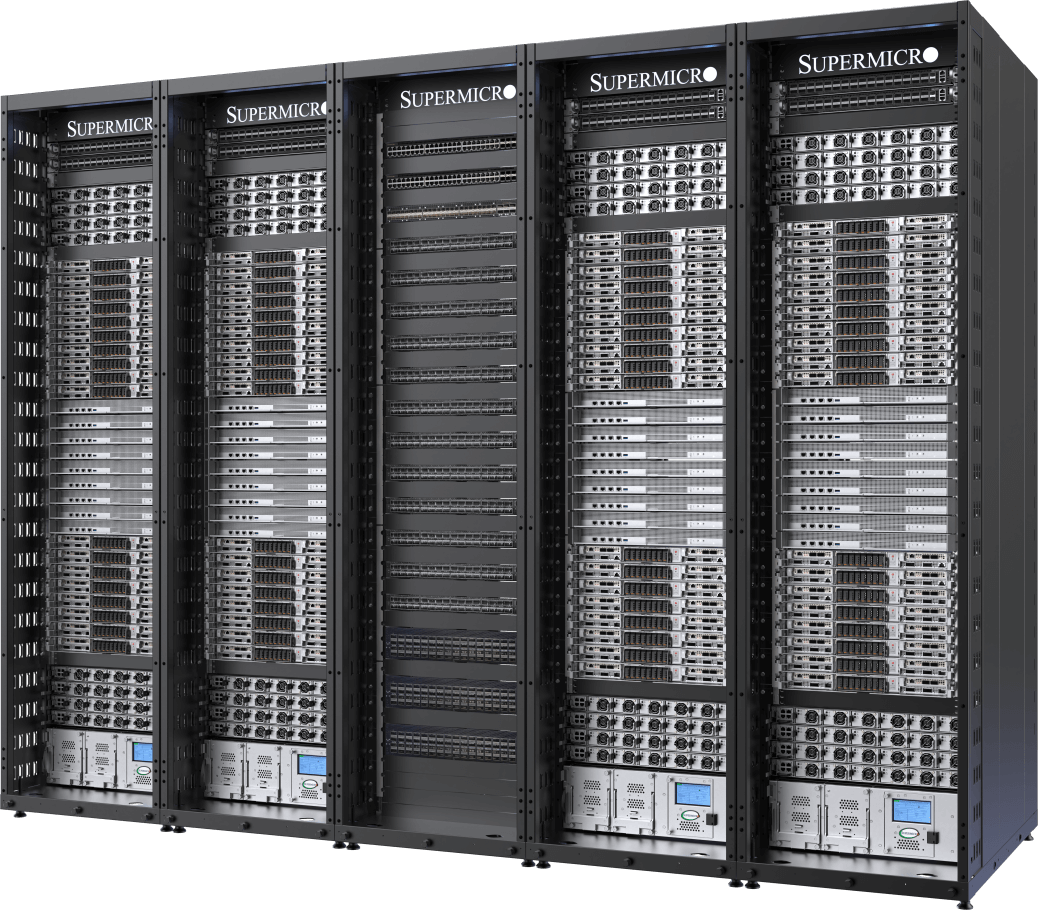

液冷式NVIDIA HGX B200AI叢集

最多可配置32組NVIDIA HGX B200 8-GPU、4U液冷系統(共256顆GPU),分布於5個機架中

- 部署頂尖AI 與推論效能,單一可擴展單元(5個機架)內配備256張NVIDIA B200 GPU

- Supermicro 250kW 容量機櫃式冷卻液分配單元 (CDU),具備冗餘電源供應器及雙熱插拔水泵

- 單一可擴展單元內含45 TB HBM3e記憶體

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIA Quantum-2 InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

氣冷式NVIDIA HGX B200 AI叢集

配備32組NVIDIA HGX B200 8-GPU、10U風冷系統(共256顆GPU),部署於9個機架中

- 經實證的業界領先架構,搭載全新熱優化風冷系統平台

- 單一可擴展單元內含45 TB HBM3e記憶體

- 採用 400Gb/s NVIDIASpectrum-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點

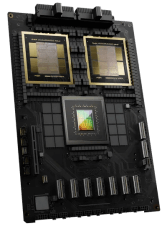

NVIDIA GB200 NVL72

單機櫃液冷式百億億次級運算系統

- 72顆 NVIDIA Blackwell B200 顯示卡整合為單一顯示單元,配備龐大的 HBM3e 記憶體池(每機架 13.5TB)

- 9x NVLink 交換器,每組運算托盤配備 4 個連接埠,可串接 72 顆 GPU,提供 1.8TB/s 的 GPU 間互連效能

- Supermicro 250kW 容量機櫃式冷卻液分配單元 (CDU),具備冗餘電源供應器及雙熱插拔水泵

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

計算托盤

- ARS-121GL-NBO-LCC

(不單獨銷售)

領先的液冷式AI叢集

配備 32 台 NVIDIA HGX H100/H200 8-GPU、4U 液冷系統(共 256 顆 GPU),分佈於 5 個機架中

- 透過Supermicro客製化液冷解決方案,將運算密度提升一倍,同時為資料中心節省高達40%的電力成本

- 單一可擴展單元內含256顆NVIDIA H100/H200 GPU

- 單一可擴展單元內配備20TB HBM3記憶體搭配H100,或36TB HBM3e記憶體搭配H200

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點

久經考驗的設計

配備32組NVIDIA HGX H100/H200 8-GPU、8U風冷系統(共256顆GPU),部署於9個機架中

- 經認證的業界領先架構,適用於大規模AI基礎設施部署

- 單一可擴展單元內含256顆NVIDIA H100/H200 GPU

- 單一可擴展單元內配備20TB HBM3記憶體搭配H100,或36TB HBM3e記憶體搭配H200

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 可客製化的AI資料管道儲存結構,提供業界領先的平行式檔案系統配置

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點