美超微展示业内首批扩展型AI和机器学习系统

台湾台北2018年5月30日电 /美通社/ -- 企业计算、存储和网络解决方案以及绿色计算技术领域的全球领导者美超微电脑股份有限公司(Super Micro Computer, Inc.) (NASDAQ: SMCI)今天宣布,该公司在2018年台湾GPU技术大会(GPU Technology Conference (GTC) Taiwan 2018)的白金赞助商展位上,展示业内最为广泛的GPU服务器平台选择,而这些GPU服务器平台支持NVIDIA® Tesla® V100 PCI-E和V100 SXM2 Tensor Core GPU加速器,5月30日至31日,2018年台湾GPU技术大会在台北万豪酒店(Taipei Marriott Hotel)举行。

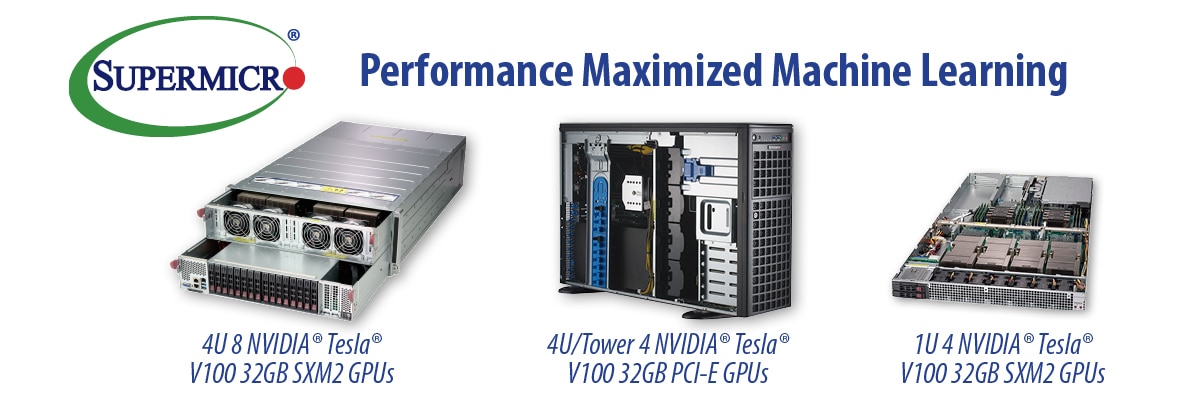

美超微采用新一代NVIDIA NVLink™互联技术的全新4U系统为最大限度地提升性能进行了优化,可以为人工智能、深度学习、自动驾驶汽车、智慧城市、医疗保健、大数据、高性能计算(HPC)和虚拟现实等高度并行的应用进行最大限度的加速。作为NVIDIA HGX-T1级GPU加速服务器平台的一部分,SuperServer 4029GP-TVRT支持8个NVIDIA Tesla V100 32GB SXM2 GPU加速器,为集群和超大规模应用提供最大的GPU到GPU带宽。这个系统结合了拥有超过5倍PCI-E 3.0带宽的最新NVIDIA NVLink技术,采用独立的GPU和CPU热区,确保为要求最高的工作负载提供不打折扣的强大性能和稳定性。

美超微总裁兼首席执行官梁见后(Charles Liang)表示:“在最初的内部基准测试中,我们的4029GP-TVRT系统每秒能够在ResNet-50上处理5188张图片,此外还能每秒在InceptionV3工作负载上处理3709张图片。当利用GPU Direct RDMA扩展到多个系统时,我们还实现了令人印象非常深刻、几乎呈线性发展的性能提升。凭借我们结合新的NVIDIA V100 32GB PCI-E和V100 32GB SXM2 GPU的最新创新成果,并在利用新一代NVLink的性能优化1U和4U系统中让内存扩大一倍,我们的客户可以加速发展他们的应用和创新,从而帮助解决世界上最为复杂、最具挑战性的问题。”

NVIDIA副总裁、加速计算部门总经理伊恩-巴克(Ian Buck)则表示:“在美超微为NVIDIA Tesla V100 32GB Tensor Core GPU优化的高密度服务器的支持下,企业客户将能获益于达到新层次的计算效率。内存扩大一倍,且V100最多推动速度提升50%,可以通过减少内存优化需求,支持创造复杂的深度学习和科学应用,并提升开发者的工作效率。”

美超微GPU系统还能支持被设计用来在任何横向扩展服务器中加速推理工作负载的超高效Tesla P4。Tesla P4中的硬件加速转码引擎可以实时提供35个高清视频流,并支持将深度学习整合进视频转码管道,为新的智能视频应用种类提供支持。深度学习以并非历史上其它计算模型的方式塑造我们的世界,更深、更复杂的神经网络被训练用来处理呈指数增长的大量数据。为了实现响应性,这些模型在强大的美超微GPU服务器上部署,以便为推理工作负载提供最大的吞吐量。

美超微还进一步展示NVIDIA SCX-E3级GPU加速服务器平台,这种性能优化4U SuperServer 4029GR-TRT2系统能够凭借美超微富有创新精神和经过GPU优化的单根复杂PCI-E设计,最多支持10个PCI-E NVIDIA Tesla V100加速器,而这能够大大提升GPU对等通信性能。SuperServer 1029GQ-TRT在仅仅1U的机架空间中最多可以支持4个NVIDIA Tesla V100 PCI-E GPU加速器,新的SuperServer 1029GQ-TVRT则能在1U机架空间中支持4个NVIDIA Tesla V100 SXM2 32GB GPU加速器,进一步提升密度,而两种1029GQ服务器都是NVIDIA SCX-E2级GPU加速器平台的一部分。

凭借让大数据分析和机器学习、最新NVIDIA GPU架构与改进后的机器学习算法结合到一起,深度学习应用要求获得多个GPU的处理能力,必须以富有效力的高效方式扩展GPU网络。美超微的单根GPU系统可以支持多个NVIDIA GPU高效联系,从而按照NCCL P2PBandwidthTest所测量的那样,最大限度地降低延迟水平和提升吞吐量。

垂询美超微NVIDIA GPU系统产品线的详细情况,请访问https://www.supermicro.com/products/nfo/gpu.cfm。