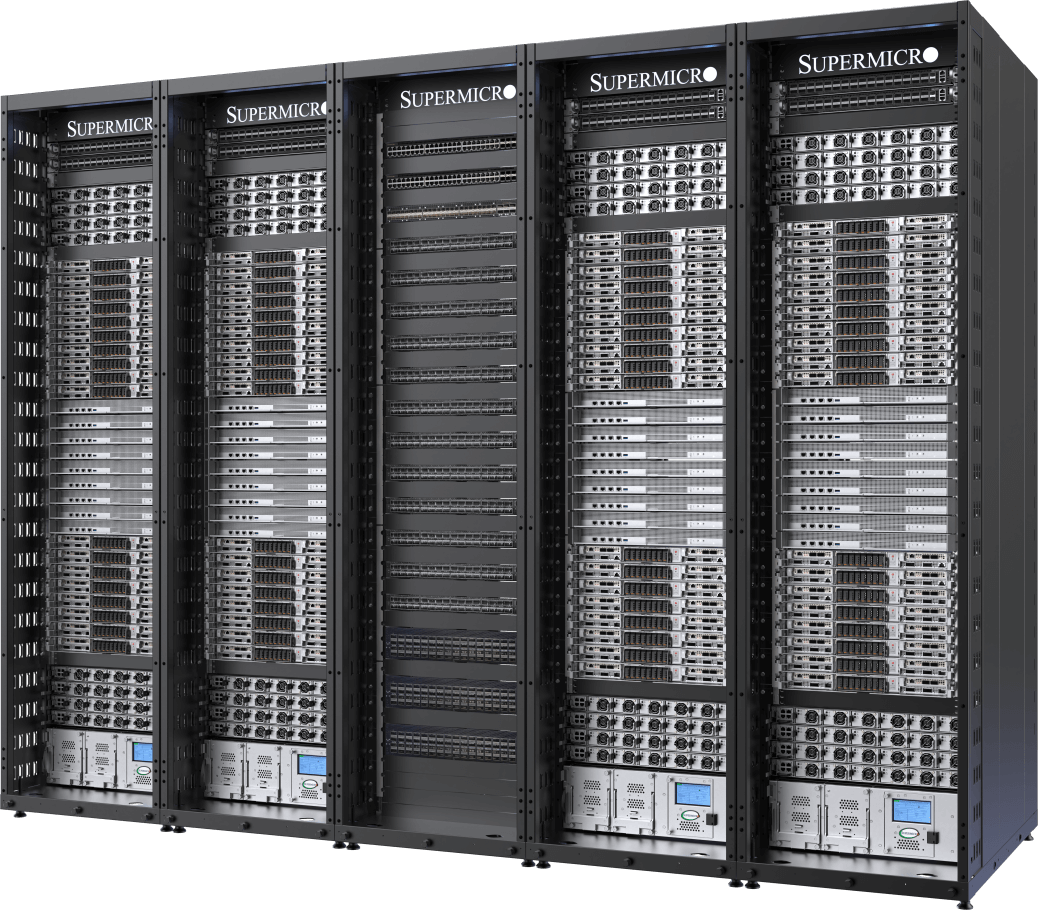

À l'ère de l'IA, une unité de calcul ne se mesure plus seulement par le nombre de serveurs. Les GPU, les CPU, la mémoire, le stockage et ces ressources interconnectés sur plusieurs nœuds dans des racks construisent l'intelligence artificielle d'aujourd'hui. L'infrastructure nécessite des réseaux à grande vitesse et à faible latence, ainsi que des technologies de refroidissement et d'alimentation électrique soigneusement conçues pour maintenir des performances et une efficacité optimales dans chaque environnement de centre de données. La solution SuperCluster de Supermicro offre des solutions de centre de données d'IA de bout en bout pour l'IA générative et les grands modèles de langage (LLM) qui évoluent rapidement.

Intégration complète à grande échelle

Conception et construction de baies et de clusters complètes avec une capacité de production globale allant jusqu'à 5,000 racks par mois

Tester, valider, déployer avec un service sur site

Les processus d'essai de niveau L11 et L12 éprouvés permettent de valider en profondeur l'efficacité opérationnelle et l'efficience avant l'expédition.

Refroidissement parliquide/refroidissement par air

Solution de refroidissement liquide ou par air entièrement intégrée avec plaques froides pour GPU et CPU, unités de distribution de refroidissement et collecteurs.

Gestion des approvisionnements et des stocks

Un guichet unique pour fournir des baies entièrement intégrées rapidement et dans les délais afin de réduire le temps de mise en œuvre de la solution et de permettre un déploiement rapide.

La solution complète de centre de données clé en main accélère le délai de livraison pour les cas d'utilisation critiques des entreprises et élimine la complexité de la construction d'un grand cluster, qui n'était auparavant réalisable que par le biais d'un design et optimisation fastidieuse des supercalculateurs.

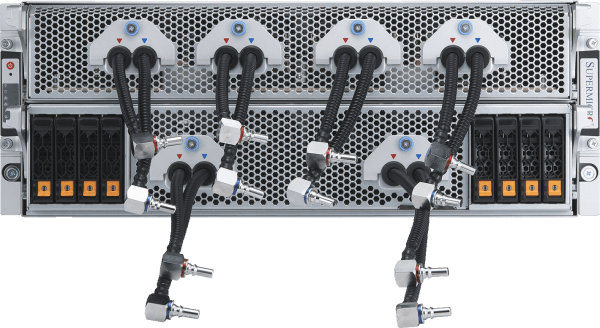

Cluster IA NVIDIA HGX B300 à 2 unités de traitement et refroidissement liquide

Cluster à 144 nœuds entièrement intégré et refroidi par liquide, pouvant accueillir jusqu'à 1 152 GPU NVIDIA B300.

- Densité de performances d'entraînement IA inégalée grâce au NVIDIA HGX B300 avec des nœuds système compacts à 2 unités de mesure et refroidissement liquide

- Refroidissement liquide Supermicro avec CDU en ligne d'une capacité de 1,8 MW (options CDU en rack disponibles)

- Grande capacité de mémoire GPU HBM3e (288 Go* de mémoire HBM3e par GPU) et empreinte mémoire système pour l'entraînement des modèles de base

- Évoluez avec NVIDIA Quantum-X800 InfiniBand pour des structures IA ultra et haut débit.

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Conçu pour prendre entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

Cluster IA NVIDIA HGX B300 4U refroidi par liquide

Cluster à 72 nœuds entièrement intégré et refroidi par liquide, pouvant accueillir jusqu'à 576 GPU NVIDIA B300

- Déployez une formation et une inférence IA hautes performances avec NVIDIA HGX B300, optimisé pour la densité de calcul et la facilité d'entretien.

- Refroidissement liquide Supermicro conçu pour un fonctionnement continu à haute puissance et une efficacité énergétique améliorée

- Grande capacité de mémoire GPU HBM3e (288 Go* de mémoire HBM3e par GPU) et empreinte mémoire système pour l'entraînement des modèles de base

- Évolutivité horizontale avec NVIDIA Spectrum™-X Ethernet ou NVIDIA Quantum-X800 InfiniBand

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Conçu pour prendre entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

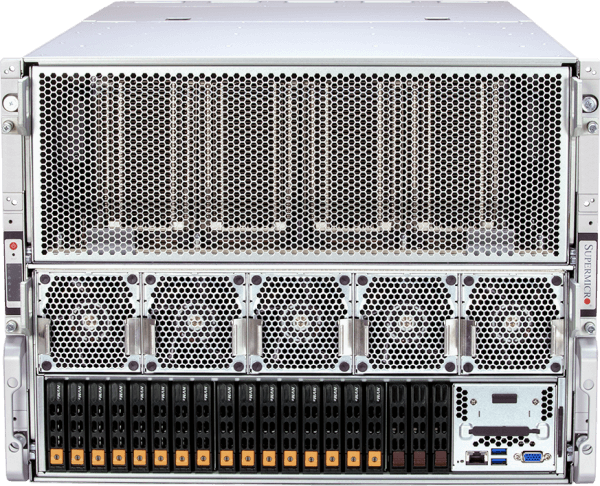

Cluster IA NVIDIA HGX B300 8U refroidi par air

Cluster à 72 nœuds entièrement intégré et refroidi par air, pouvant accueillir jusqu'à 576 GPU NVIDIA B300

- Déployez une formation et une inférence IA évolutives avec NVIDIA HGX B300 dans une conception refroidie par air pour une compatibilité plus large avec les centres de données.

- Conception thermique et flux d'air optimisés permettant un fonctionnement hautement performant sans infrastructure de refroidissement liquide

- Grande capacité de mémoire GPU HBM3e (288 Go* de mémoire HBM3e par GPU) et empreinte mémoire système pour l'entraînement des modèles de base

- Évolutivité horizontale avec NVIDIA Spectrum™-X Ethernet ou NVIDIA Quantum-X800 InfiniBand

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Conçu pour prendre entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

Cluster IA NVIDIA HGX B200 refroidi par liquide

Avec jusqu'à 32 systèmes NVIDIA HGX B200 8-GPU, 4U refroidis par liquide (256 GPU) dans 5 racks

- Déployez le summum des performances d'entraînement et d'inférence IA avec 256 GPU NVIDIA B200 dans une unité évolutive (5 racks).

- Refroidissement liquide direct Supermicro comprenant une unité de distribution du liquide de refroidissement (CDU) de 250 kW de capacité dans le rack avec PSU redondant et deux pompes remplaçables à chaud.

- 45 To de mémoire HBM3e dans une unité évolutive

- Évolution avec l'Ethernet NVIDIA Spectrum™-X à 400 Gb/s ou l'InfiniBand NVIDIA Quantum-2

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Conçu pour prendre entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

Cluster IA NVIDIA HGX B200 refroidi par air

Avec 32 systèmes NVIDIA HGX B200 8-GPU, 10U refroidis par air (256 GPU) dans 9 racks

- Architecture de référence reconnue dans l’industrie, intégrant une nouvelle plateforme à refroidissement par air optimisée pour les performances thermiques

- 45 To de mémoire HBM3e dans une unité évolutive

- Évolutivité avec Ethernet NVIDIA Spectrum-X à 400 Gb/s ou NVIDIA Quantum-2 InfiniBand

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Nœuds système certifiés NVIDIA, prenant entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

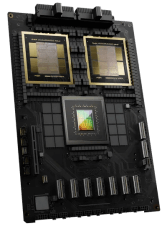

NVIDIA GB200 NVL72

Un calculateur Exascale à refroidissement liquide dans un seul rack

- 72 GPU NVIDIA Blackwell B200 fonctionnant comme un seul GPU avec un pool massif de mémoire HBM3e (13,5 To par rack)

- Commutateur NVLink 9x, 4 ports par plateau informatique connectant 72 GPU pour fournir une interconnexion GPU-GPU de 1,8 To/s

- Refroidissement liquide direct Supermicro comprenant une unité de distribution du liquide de refroidissement (CDU) de 250 kW de capacité dans le rack avec PSU redondant et deux pompes remplaçables à chaud.

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Évolutivité avec Ethernet NVIDIA Spectrum™-X à 400 Gb/s ou NVIDIA Quantum-2 InfiniBand

- Conçu pour prendre entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Serveur de calcul

- ARS-121GL-NBO-LCC

(non vendu individuellement)

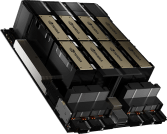

Premier cluster d'IA à refroidissement

Avec 32 systèmes NVIDIA HGX H100/H200 8-GPU, 4U refroidis par liquide (256 GPU) dans 5 racks

- Doublement de la densité de calcul grâce à la solution de refroidissement liquide personnalisée de Supermicro, avec une réduction de 40 % des coûts d'électricité pour le centre de données

- 256 GPU NVIDIA H100/H200 dans une unité évolutive

- 20 To de HBM3 avec H100 ou 36 To de HBM3e avec H200 dans une unité évolutive

- Options de structure de stockage dédiées avec prise en charge complète de NVIDIA GPUDirect RDMA et Storage ou RoCE

- Évolutivité avec Ethernet NVIDIA Spectrum™-X à 400 Gb/s ou NVIDIA Quantum-2 InfiniBand

- Nœuds système certifiés NVIDIA, prenant entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul

Conception éprouvée

Avec 32 systèmes NVIDIA HGX H100/H200 8-GPU, 8U refroidis par air (256 GPU) dans 9 racks

- Architecture de pointe éprouvée pour les déploiements d'infrastructure d'IA à grande échelle.

- 256 GPU NVIDIA H100/H200 dans une unité évolutive

- 20 To de HBM3 avec H100 ou 36 To de HBM3e avec H200 dans une unité évolutive

- Évolutivité avec Ethernet NVIDIA Spectrum™-X à 400 Gb/s ou NVIDIA Quantum-2 InfiniBand

- Structure de stockage personnalisable pour le flux des données d'IA avec des intégrations de système de fichiers de type parallèles.

- Nœuds système certifiés NVIDIA, prenant entièrement en charge les plateformes logicielles d'IA NVIDIA, notamment NVIDIA AI Enterprise et NVIDIA Run:ai.

Nœud de calcul