| |

|

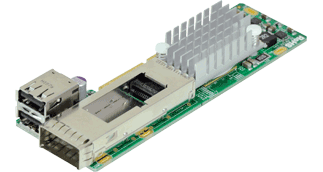

Compact and Powerful InfiniBand FDR Adapter

The AOC-CIBF-m1 is the most compact, yet powerful, InfiniBand adapter in the market. Based on Mellanox® ConnectX-3 with Virtual Protocol Interconnect (VPI), it provides the highest performing and most flexible interconnect solution for servers used in Enterprise Data Centers and High-Performance Computing. The AOC-CIBF-m1 simplifies the system development by serving both InfiniBand and Ethernet fabrics in one hardware design. The AOC-CIBF-m1 is designed in a small microLP form factor to fit Supermicro Twin server systems. |

|

Ce produit est uniquement disponible auprès de Supermicro. |

| | | |

|

- Connecteur QSFP unique

- Facteur de forme MicroLP

- PCI Express 3.0 (jusqu'à 8GT/s)

- Interconnexion de protocole virtuel (VPI)

- 1µs MPI ping latency

- Jusqu'à 56 Gbps InfiniBand ou 40 Gbps Ethernet

- Délestage de l'unité centrale des opérations de transport

- Déchargement des applications

- Accélération des communications par le GPU

- QoS de bout en bout et contrôle de la congestion

- Virtualisation des E/S basée sur le matériel

- Encapsulation Ethernet (EoIB)

- Conformité RoHS 6/6

|

| | |

| RoHS

|

- Conforme RoHS 6/6, sans Pb

|

| | |

| | Guide de l'utilisateur |

[ Télécharger ] (2.18MB) |

| Fiche technique |

[ Télécharger ] |

| Conducteur |

Choisissez le dernier dossier CDR-NIC, puis cliquez sur le dossier Mellanox pour le pilote [ Download Site ] |

| CD de pilotes |

Cliquez sur le dernier fichier ISO CDR-NIC pour le télécharger [ Download Site ] |

| Firmware |

[ Télécharger ] |

|

|

| |

|

- Généralités

- Contrôleur Mellanox® ConnectX-3 FDR

- Format compact microLP

- Un seul port QSFP et deux ports USB 2.0

- Interface PCI-E 3.0 x8 (8GT/s)

- Connectivité

- Interopérable avec les commutateurs InfiniBand ou 10/40GbE

- Câble en cuivre passif avec protection ESD

- Connecteurs alimentés pour la prise en charge des câbles optiques et actifs

- InfiniBand

- Conforme à la spécification IBTA 1.2.1

- Contrôle de congestion basé sur le matériel

- 16 millions de canaux d'E/S

- MTU de 256 à 4Kbytes, messages de 1Gbyte

- InfiniBand amélioré

- Transport fiable basé sur le matériel

- Déchargement des opérations collectives

- Accélération de la communication par le GPU

- Multidiffusion fiable basée sur le matériel

- Transport connecté fiable étendu

- Opérations atomiques améliorées

- Ethernet

- IEEE Std 802.3ae 10 Gigabit Ethernet

- IEEE Std 802.3ba 40 Gigabit Ethernet

- IEEE Std 802.3ad Agrégation de liens et basculement

- IEEE Std 802.3az Ethernet à faible consommation d'énergie

- IEEE Std 802.1Q, .1p Balises VLAN et priorité

- IEEE Std 802.1Qau Notification de congestion

- IEEE P802.1Qaz D0.2 ETS

- IEEE P802.1Qbb D1.0 Contrôle de flux basé sur la priorité

- Prise en charge des trames Jumbo (9,6 Ko)

- Virtualisation des E/S basée sur le matériel

- IOV à racine unique

- Traduction et protection des adresses

- Ressources d'adaptateur dédiées

- Plusieurs files d'attente par machine virtuelle

- QoS améliorée pour les vNIC

- Prise en charge de VMware NetQueue

- Fonctionnalités de gestion

- Décharges CPU supplémentaires

- RDMA sur Ethernet convergé

- Délestage TCP/UDP/IP sans état

- Coalescence intelligente des interruptions

- Technologie Flexboot™

- Démarrage à distance sur InfiniBand

- Amorçage à distance sur Ethernet

- Démarrage à distance via iSCSI

- Prise en charge des protocoles

- Open MPI, OSU MVAPICH, Intel MPI, MS

- MPI, Platform MPI

- TCP/UDP, EoIB, IPoIB, SDP, RDS

- SRP, iSER, NFS RDMA

- uDAPL

- Systèmes d'exploitation/distributions

- Novell SLES, Red Hat Enterprise Linux (RHEL),

et autres distributions Linux

- Microsoft Windows Server 2008/CCS 2003, HPC Server 2008

- OpenFabrics Enterprise Distribution (OFED)

- OpenFabrics Windows Distribution (WinOF)

- VMware ESX Server 3.5, vSphere 4.0/4.1

- Conditions de fonctionnement

- Température de fonctionnement : 0°C à 55°C (32°F à 131°F)

- Dimensions physiques (L x l)

- Dimensions du circuit imprimé de la carte (sans les supports d'extrémité) :

12,32cm (4,85in) x 3,90cm (1,54in)

|

|