深入了解NVIDIA Blackwell

在AI技術不斷轉型的此刻,持續變化的Scaling Law也需基於更高的資料中心性能。我們與NVIDIA密切合作,推出最新NVIDIA Blackwell解決方案,並結合新一代氣冷式與液冷式架構,提供空前的運算效能、密度與效率。Supermicro透過可立即部署的AI資料中心建構組件解決方案,提供了能加速AI創新的永續、先進技術,是NVIDIA Blackwell部署與應用方面的最佳合作夥伴。

端對端AI資料中心建構組件解決方案的優勢

提供多種CPU 的廣泛風冷與液冷系統、完整的數據中心管理軟體套件、具備完整網路佈建、線纜佈線及叢集層級L12驗證的交鑰匙機架級整合方案,以及全球交付、技術支援與維運服務。

- 豐富經驗

- AI 建構模組解決方案,驅動全球規模最大的液冷式AI 中心部署。

- 彈性方案

- 空氣或液冷式、GPU 優化、多種系統與機架規格、CPU、儲存裝置、網路選項。可依需求進行優化。

- 液冷先驅

- 經過驗證、可擴展且即插即用的液冷解決方案,為AI 提供強大支援。專為 NVIDIA Blackwell 架構量身打造。

- 快速上線

- 憑藉全球運能實現加速交付,結合頂尖部署專業技術與單一據點服務,助您快速將AI 生產AI 。

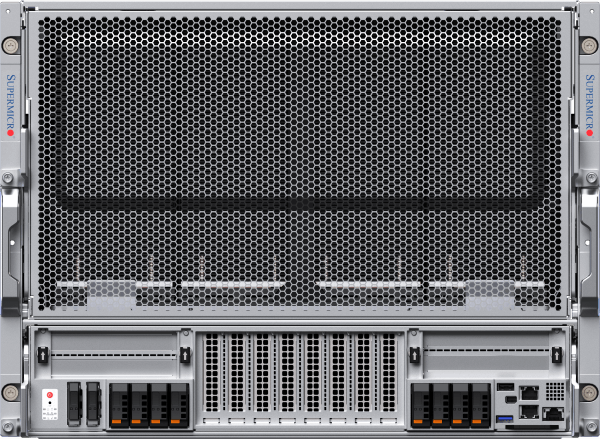

最緊湊的超大規模AI

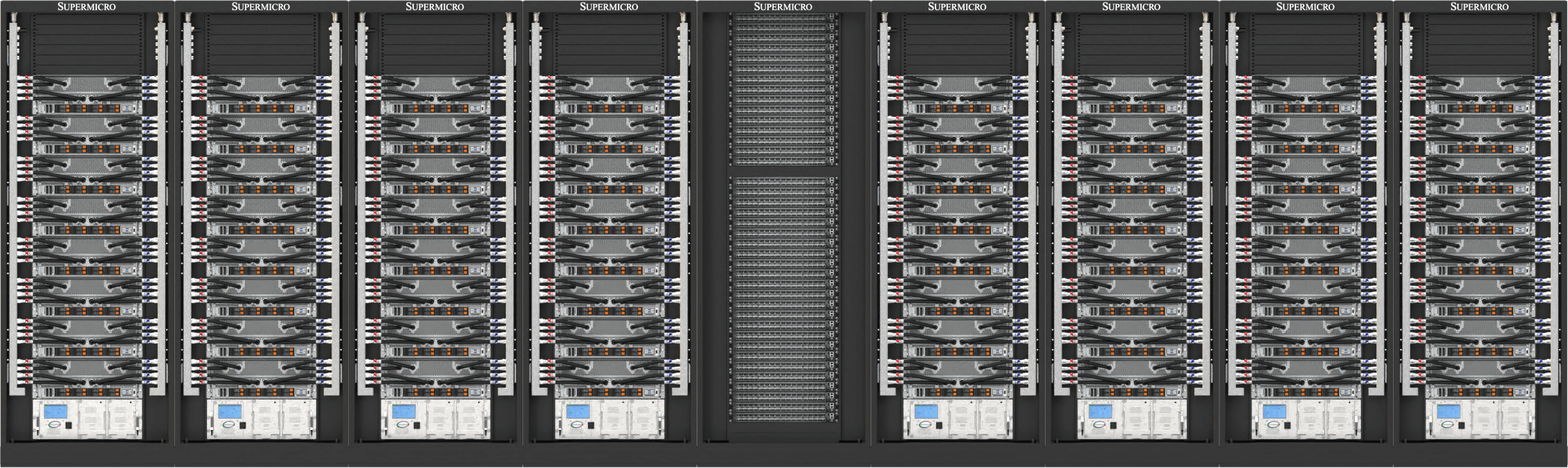

NVIDIA HGX™ B300 系統針對 OCP ORV3 設計進行優化,單機架最高可容納 144 顆 GPU

Supermicro液冷式NVIDIA HGX B300系統,為超大規模部署提供無與倫比的GPU密度。採用先進DLC-2技術打造,符合OCP ORV3規範,每個緊湊型8-GPU節點可安裝於21英寸機架,每機架最多支援18個節點,總計可容納144顆GPU。 系統採用盲插式歧管連接與模組化CPU 架構,在維持每顆B300 GPU高達1,100W TDP效能的同時,大幅降低機架佔用空間、功耗及散熱成本。此設計完美契合需兼顧極致效能密度與卓越AI 。

2-OU 液冷系統

適用於 NVIDIA HGX B300 8-GPU

標準化ORV3機架中最多可容納144張NVIDIA BlackwellUltra

Ultra AI

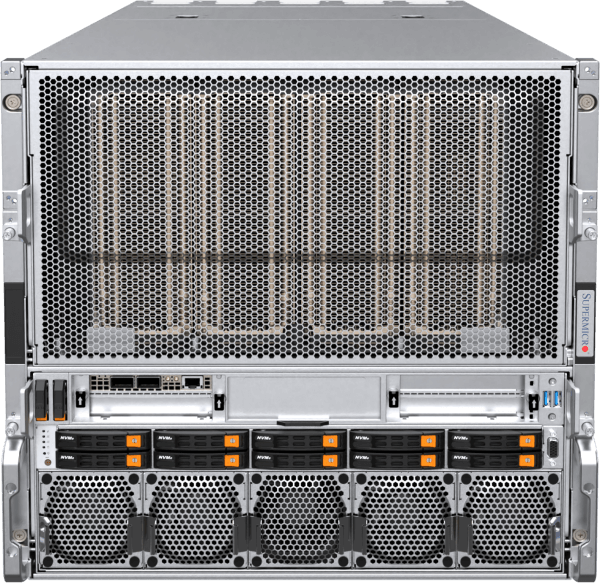

NVIDIA HGX™ B300 採用最先進的風冷與液冷架構

Supermicro HGX 平台驅動著全球眾多大型AI ,為當今顛覆性的AI 提供運算輸出。此款 8U 風冷系統現搭載 NVIDIA BlackwellUltra 晶片,透過八顆 1100W HGX B300 GPU 搭配總計 2.3TB 的 HBM3e 記憶體,實現極致效能表現。 八組前置OSFP埠整合ConnectX®-8SuperNIC網路卡,提供800Gb/s傳輸速率,可快速部署NVIDIA Quantum-X800 InfiniBand或Spectrum-X™乙太網路叢集。 4U液冷系統採用DLC-2技術,具備98%熱能捕獲率,實現40%的數據中心節能效益。Supermicro 模組化解決方案®(DCBBS)結合現場部署專業技術,提供液冷系統、網路拓撲與佈線、供電系統及熱管理等完整解決方案,AI 上線時程。

4U液冷式或8U風冷式系統

適用於 NVIDIA HGX B300 8-GPU

前置 I/O 液冷系統,整合 NVIDIAConnectX-8800 Gb/s 網路

NVIDIA BlackwellUltra B300 8-GPU 前置 I/O 風冷系統,整合 NVIDIAConnectX-8網路功能

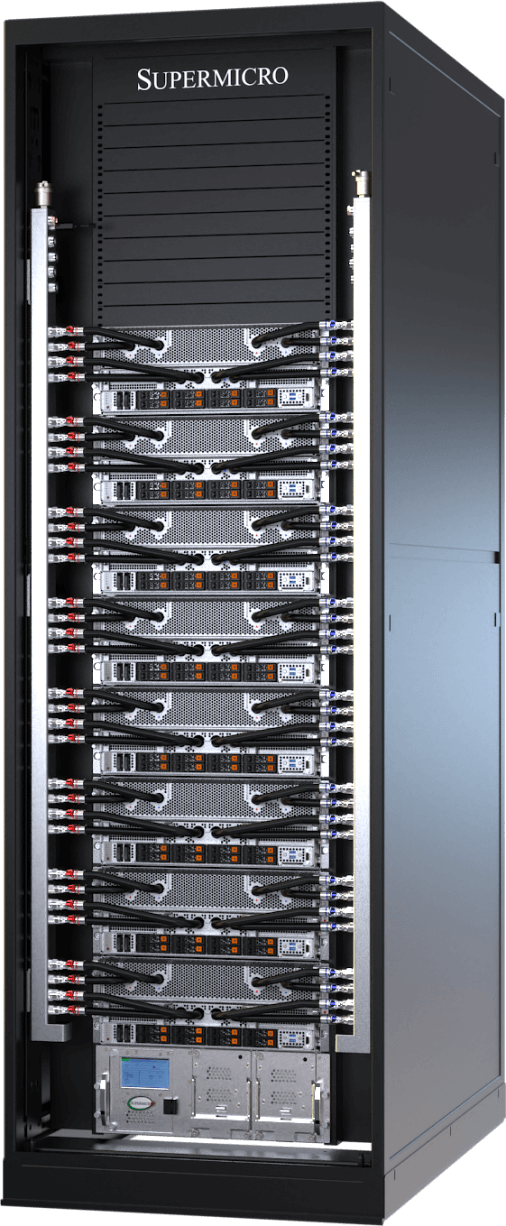

機架級的百億億次運算

NVIDIA GB300 NVL72 端到端液冷解決方案

Supermicro GB300 NVL72 超級伺服器全面應AI 需求,從基礎模型訓練到大規模推理推演皆能勝任。其結合頂尖AI 與Supermicro 直接液冷技術,實現極致運算密度與效能。基於 NVIDIA BlackwellUltra 架構,單機架整合 72 顆 NVIDIA B300 GPU,每顆配備 288GB HBM3e 記憶體。 憑藉1.8TB/s NVLink互連技術,GB300 NVL72單節點即可發揮百億億次級超級電腦效能。升級的網路架構使運算網格性能倍增,支援800Gb/s傳輸速率。Supermicro製造產能與端到端服務,加速液冷AI 部署進程,並縮短GB300 NVL72叢集的上市週期。

NVIDIA GB300 NVL72 與 GB200 NVL72

適用於 NVIDIA GB300/GB200 Grace™ BlackwellSuperchip

單一 NVIDIA NVLink 域內搭載 72 顆 NVIDIA BlackwellUltra 。現已具備Ultra 與擴展性

單一 NVIDIA NVLink 域內整合 72 顆 NVIDIA Blackwell 處理器。AI 的巔峰之作。

風冷系統,進化版

最暢銷的風冷系統經重新設計與優化,專為 NVIDIA HGX B200 8-GPU 打造

全新風冷式 NVIDIA HGX B200 8-GPU 系統具備強化散熱架構、CPU/記憶體/儲存/網路的高彈性配置能力,並從前後兩側提升維運便利性。 單個機架可安裝並完全整合多達四台新型8U/10U風冷系統,在維持與前代相同密度的前提下,提供高達15倍的推論效能與3倍的訓練效能。 所有Supermicro HGX B200 系統均配備 1:1 GPU 對 NIC 比例,支援 NVIDIABlueField®-3或 NVIDIAConnectX®-7,可擴展至高效能運算架構。

8U前置 I/O或 10U後置 I/O風冷系統

適用於 NVIDIA HGX B2008-GPU

前置I/O風冷系統,具備強化系統記憶體配置彈性與冷通道可維護性

後置I/O風冷設計,適用於大型語言模型訓練與高吞吐量推論

次世代液冷系統

單機架最高可容納96張NVIDIA HGX™ B200 GPU,實現極致擴展性與效能

全新前置I/O液冷式4U NVIDIA HGX B2008-GPU系統Supermicro技術。直接液冷技術現可吸收高達92%的伺服器元件產熱,CPU、GPU、PCIe交換器、DIMM、VRM及PSU等元件,實現最高40%的資料中心節能效益,並將噪音水準降至低至50分貝。 此全新架構進一步提升了前代產品的效能與可維護性,該前代產品原為 NVIDIA HGX H100/H2008 GPU系統所設計。 此機架級設計提供42U、48U或52U配置選項,搭載新型垂直冷卻液分配管路(CDM)後,水平管路不再佔用寶貴機架空間。此設計使42U機架可容納8套系統(共64張NVIDIA Blackwell GPU),52U機架則可容納多達12套系統(共96張NVIDIA GPU)。

4U前置 I/O 或後置 I/O液冷系統

適用於 NVIDIA HGX B2008-GPU

前置I/O DLC-2液冷系統,可節省高達40%的數據中心電力消耗,噪音水平低至50分貝

後置I/O液冷系統,專為實現最高運算密度與效能而設計

即插即用可擴展單元,可快速部署於 NVIDIA Blackwell 平台

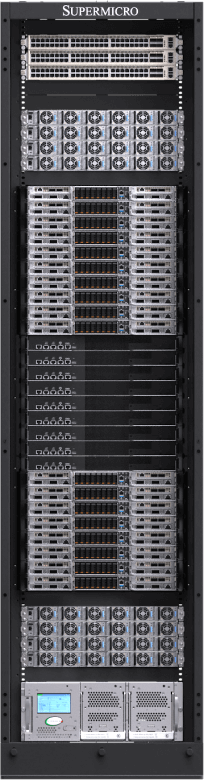

全新SuperCluster設計提供42U、48U或52U機架配置,適用於風冷或液冷資料中心。其採用集中式機架整合NVIDIA Quantum InfiniBand或NVIDIA Spectrum™網路技術,液冷式SuperCluster可實現非阻塞式 256 GPU可擴展單元(配置於五組42U/48U機架),或768 GPU可擴展單元(配置於九組52U機架),滿足最先進AI 中心部署需求。Supermicro 提供列式冷卻單元(CDU)選項以支援大規模部署,以及無需設施供水之液冷轉氣冷機架解決方案。 風冷式SuperCluster設計延續前代業界領先的成熟架構,可於九個48U機架中實現256 GPU可擴展單元。

端到端資料中心建構模組解決方案與部署服務,適用於 NVIDIA Blackwell

Supermicro 全球製造規模的全方位一站式解決方案Supermicro 資料中心級解決方案設計、液冷技術、交換設備、佈線系統、完整資料中心管理軟體套件、L11與L12解決方案驗證、現場安裝以及專業支援服務。 憑藉遍佈聖荷西、歐洲及亞洲的生產基地Supermicro 業界無可匹敵的液冷/風冷機架系統製造能力,確保準時交付、降低總擁有成本(TCO)並維持穩定品質。

SupermicroNVIDIA Blackwell 解決方案採用集中式機架設計,整合 NVIDIA Quantum InfiniBand 或 NVIDIA Spectrum™ 網路技術,實現最佳基礎架構擴展與 GPU 叢集效能。此架構可配置為五機架的非阻塞式 256 GPU 可擴展單元,或九機架的擴展型 768 GPU 可擴展單元。 此架構原生支援NVIDIA企業級軟體,結合Supermicro部署全球最大液冷資料中心的專業技術,為當今最具野心的AI 中心專案提供卓越效能與無可匹敵的上線速度。

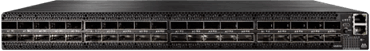

NVIDIA Quantum InfiniBand 與 Spectrum 以太網路

mainstream 伺服器到高效能超級電腦,NVIDIA Quantum InfiniBand 與 Spectrum™ 網路技術實現最具擴展性、速度最快且安全的端到端網路解決方案。

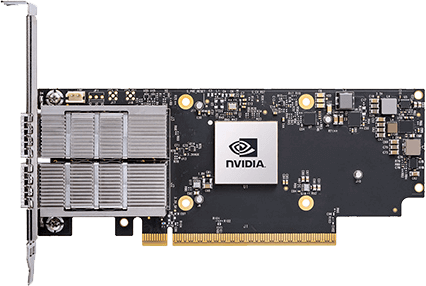

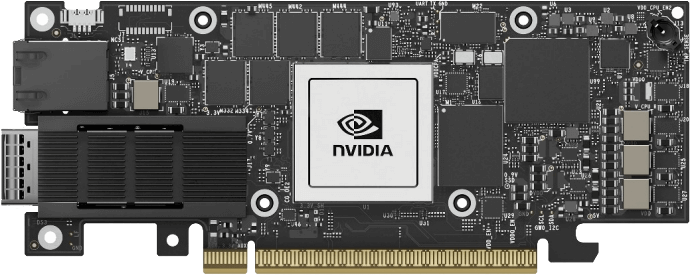

NVIDIA 超級網路介面卡

Supermicro NVIDIA 超級網路介面卡:適用於 InfiniBand 的 NVIDIA ConnectX 以及適用於乙太網路的 NVIDIABlueField-3超級網路介面卡。所有SupermicroNVIDIA HGX B200 系統均配備 1:1 網路連接至每顆 GPU,以啟用 NVIDIA GPUDirect RDMA(InfiniBand)或 RoCE(乙太網路),實現大規模平行AI 。

NVIDIAAI 軟體

完整存取 NVIDIA 應用框架、API、SDK、工具包及優化工具,並具備部署AI 、NVIDIA NIM、RAG 以及最新優化AI 模型的能力。NVIDIAAI 軟體透過企業級安全性、支援與穩定性,簡化生產級AI 開發與部署流程,確保從原型到生產的無縫過渡。