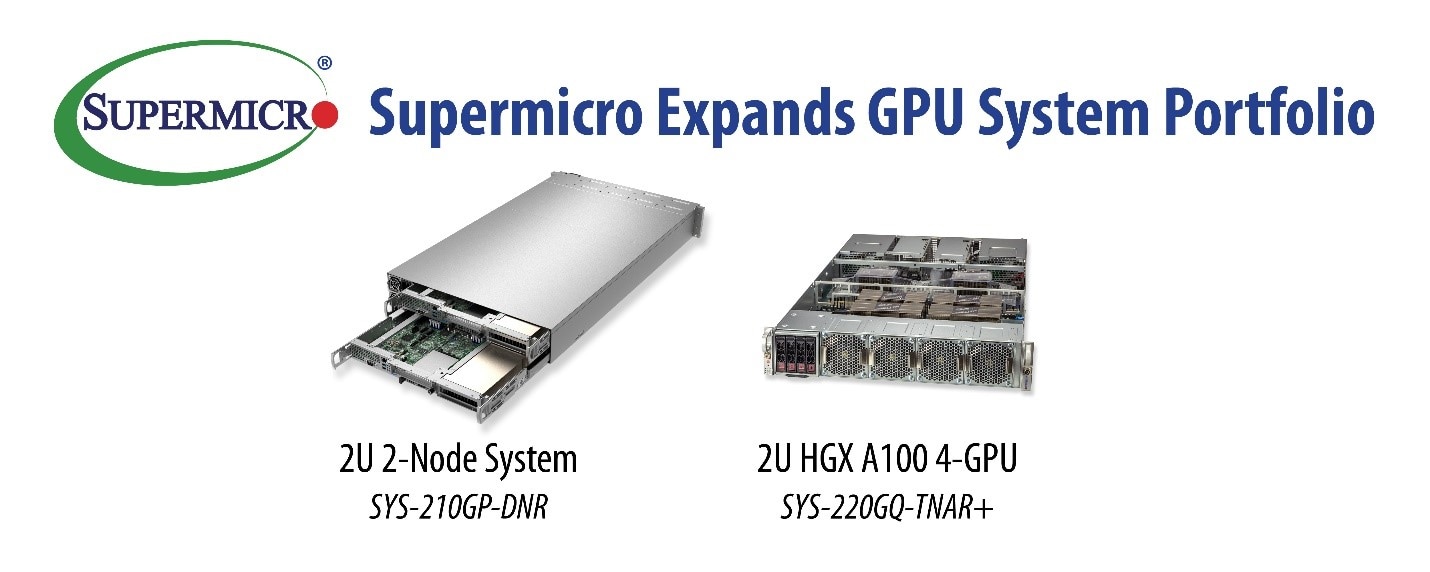

Supermicro 持續擴展 GPU 系統產品組合 推出創新的全新伺服器加快各種 AI、HPC 和雲端工作負載的速度

2021 年 10 月 12 日,加州聖荷西訊 — Super Micro Computer, Inc. (SMCI) 為企業級運算、儲存、網路解決方案和綠色運算技術等領域的全球領導者,宣佈推出搭載 NVIDIA® Ampere architecture GPU 以及內建AI加速器的第3代 Intel Xeon 可擴充處理器的全新系統 (Supermicro X12 系列)。這些伺服器是專為需要低延遲和高應用效能的 AI 應用所設計。2U NVIDIA HGX A100 4-GPU 系統適於大規模部署具有高速 CPU-GPU 和 GPU-GPU 互連的現代 AI 訓練叢集。而Supermicro 2U 2-Node 系統則可透過共享電源供應和冷卻風扇來減少能耗和成本,降低碳排放,同時可因應工作負載選用多款GPU 加速器。這兩款系統皆內含由最新 Intel Software Guard Extensions (Intel® SGX) 所啟用的進階安全功能。

Supermicro 總裁暨執行長 Charles Liang 表示:「Supermicro 工程師為我們豐富多元的高效能GPU 伺服器系列再度打造出全新產品,與市場上其他設計相比,更能節省成本、空間以及能耗。憑藉創新的設計,我們為客戶的AI 和 HPC (高效能運算) 工作負載,提供可搭載 4個NVIDIA HGX A100 (代號:Redstone) GPU 加速器的2U高密度GPU系統。此外,我們的 2U 2 節點系統經過獨特設計,可共用電源供應和散熱元件,進而降低營運成本以及對環境的影響。」

此款2U NVIDIA HGX A100 伺服器採用第3代 Intel Xeon 可擴充處理器平台,支援Intel Deep Learning Boost Technology,且針對分析、訓練和推論工作負載進行了最佳化設計。 此系統可搭載 4顆A100 GPU並以NVIDIA NVLink® 技術完全互連,提供高達 2.5 petaflops 的 AI 性能。其高達 320GB 的 GPU 記憶體,可加速企業資料科學以及 AI 方面的突破。對於像是 BERT 大型推論等複雜型對話式 AI 模型,此系統比上一代 GPU的演算快了 4 倍,而在 BERT 大型 AI 訓練方面則有 3 倍的性能提升。

此外,這些系統採用進階的散熱和冷卻設計,成為優先考慮節點密度和電源效率的高效能叢集的理想選擇。也可以採用液冷系統,從而省下更多的營運成本。此平台亦支援 Intel Optane™ 持續性記憶體 (PMem),在 GPU 上進行處理之前,可以將更大的模型儲存在接近 CPU 的記憶體內。對於需要多系統互動的應用,系統還可以配備4張NVIDIA ConnectX®-6 200Gb/s 網速的 InfiniBand 卡,以 1:1 GPU-DPU的比例支援 GPUDirect RDMA。

全新的 2U 2 節點是一種節能、省資源的架構,設計能讓每個節點支援最多三張雙倍寬度 GPU。每個節點還配備一個具有多達 40 個核心、內建AI及HPC加速器的第3代 Intel Xeon 可擴充處理器。各種 AI、渲染和 VDI 應用都能從這種 CPU 和 GPU 的平衡設計中受益。該系統配備 Supermicro 的進階 I/O 模組 (AIOM) 擴充插槽,具有快速靈活的網路連線功能,可在執行工作負載及處理深度學習模式時負荷龐大的資料流量,滿足高度需求的 AI/ML 應用程式、深度學習訓練和推論。本系統也是多執行個體的高階雲端遊戲和許多其他運算密集型 VDI 應用程式的理想選擇。此外,虛擬內容交付網路 (vCDN) 能滿足對串流服務日益增長的需求。系統內建備援的電源供應器,發生故障時,任何一個節點都能使用相鄰節點的電源供應器。