美超微展示業內首批擴展型AI和機器學習系統

台灣台北2018年5月30日電 /美通社/ -- 企業運算、存儲和網絡解決方案以及綠色運算技術領域的全球領導者美超微電腦股份有限公司(Super Micro Computer, Inc.) (NASDAQ: SMCI)今天宣佈,該公司在2018年台灣GPU技術大會(GPU Technology Conference (GTC) Taiwan 2018)的白金贊助商展位上,展示業內最為廣泛的GPU服務器平台選擇,而這些GPU服務器平台支持NVIDIA® Tesla® V100 PCI-E和V100 SXM2 Tensor Core GPU加速器,5月30日至31日,2018年台灣GPU技術大會在台北萬豪酒店(Taipei Marriott Hotel)舉行。

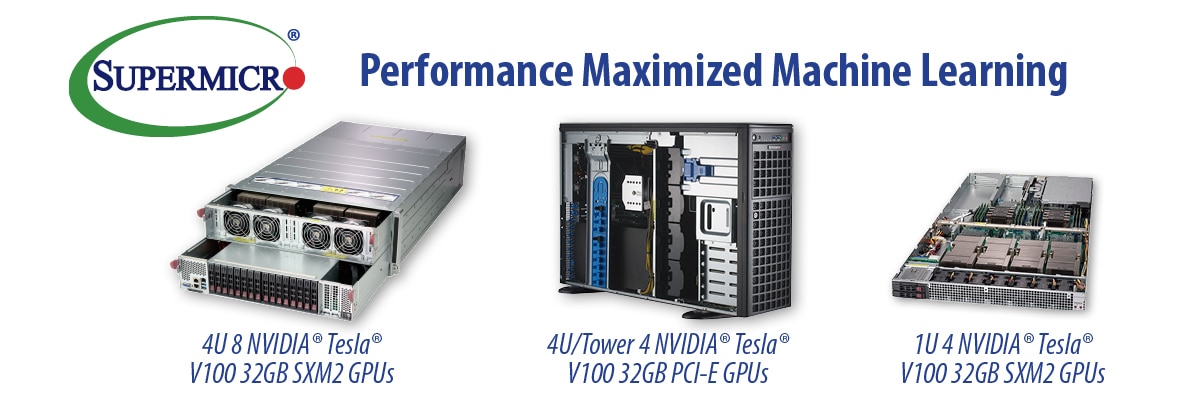

美超微採用新一代NVIDIA NVLink™互聯技術的全新4U系統為最大限度地提升性能進行了優化,可以為人工智能、深度學習、自動駕駛汽車、智能城市、醫療保健、大數據、高性能運算(HPC)和虛擬實境等高度並行的應用進行最大限度的加速。作為NVIDIA HGX-T1級GPU加速服務器平台的一部分,SuperServer 4029GP-TVRT支持8個NVIDIA Tesla V100 32GB SXM2 GPU加速器,為叢集和超大規模應用提供最大的GPU到GPU頻寬。這個系統結合了擁有超過5倍PCI-E 3.0頻寬的最新NVIDIA NVLink技術,採用獨立的GPU和CPU熱區,確保為要求最高的工作負載提供不打折扣的強大性能和穩定性。

美超微總裁兼CEO梁見後(Charles Liang)表示:「在最初的內部基準測試中,我們的4029GP-TVRT系統每秒能夠在ResNet-50上處理5188張圖片,此外還能每秒在InceptionV3工作負載上處理3709張圖片。當利用GPU Direct RDMA擴展到多個系統時,我們還實現了令人印象非常深刻、幾乎呈線性發展的性能提升。憑藉我們結合新的NVIDIA V100 32GB PCI-E和V100 32GB SXM2 GPU的最新創新成果,並在利用新一代NVLink的性能優化1U和4U系統中讓內存擴大一倍,我們的客戶可以加速發展他們的應用和創新,從而幫助解決世界上最為複雜、最具挑戰性的問題。」

NVIDIA副總裁、加速運算部門總經理Ian Buck則表示:「在美超微為NVIDIA Tesla V100 32GB Tensor Core GPU優化的高密度服務器的支持下,企業客戶將能獲益於達到新層次的運算效率。內存擴大一倍,且V100最多推動速度提升50%,可以透過減少內存優化需求,支持創造複雜的深度學習和科學應用,並提升開發者的工作效率。」

美超微GPU系統還能支持被設計用來在任何橫向擴展服務器中加速推理工作負載的超高效Tesla P4。Tesla P4中的硬件加速轉碼引擎可以即時提供35個高清視像串流,並支持將深度學習整合進視像轉碼管道,為新的智能視像應用種類提供支持。深度學習以並非歷史上其它運算模型的方式塑造我們的世界,更深、更複雜的神經網絡被訓練用來處理呈指數增長的大量數據。為了實現響應性,這些模型在強大的美超微GPU服務器上部署,以便為推理工作負載提供最大的傳輸量。

美超微還進一步展示NVIDIA SCX-E3級GPU加速服務器平台,這種性能優化4U SuperServer 4029GR-TRT2系統能夠憑藉美超微富有創新精神和經過GPU優化的單根複雜PCI-E設計,最多支持10個PCI-E NVIDIA Tesla V100加速器,而這能夠大大提升GPU對等通訊性能。SuperServer 1029GQ-TRT在僅僅1U的機架空間中最多可以支持4個NVIDIA Tesla V100 PCI-E GPU加速器,新的SuperServer 1029GQ-TVRT則能在1U機架空間中支持4個NVIDIA Tesla V100 SXM2 32GB GPU加速器,進一步提升密度,而兩種1029GQ服務器都是NVIDIA SCX-E2級GPU加速器平台的一部分。

憑藉讓大數據分析和機器學習、最新NVIDIA GPU架構與改進後的機器學習算法結合到一起,深度學習應用要求獲得多個GPU的處理能力,必須以富有效力的高效方式擴展GPU網絡。美超微的單根GPU系統可以支持多個NVIDIA GPU高效聯繫,從而按照NCCL P2PBandwidthTest所測量的那樣,最大限度地降低延遲水平和提升傳輸量。

查詢美超微NVIDIA GPU系統產品線的詳細情況,請瀏覽https://www.supermicro.com/products/nfo/gpu.cfm。