Supermicro Breakthrough Universal GPU System – Supports All Major CPU, GPU, and Fabric Architectures

San Jose, Calif., March 21, 2022 – Super Micro Computer, Inc. (SMCI), a global leader in enterprise computing, storage, networking solutions, and green computing technology, has announced a revolutionary technology that simplifies large scale GPU deployments and is a future proof design that supports yet to be announced technologies. The Universal GPU server provides the ultimate flexibility in a resource-saving server.

The Universal GPU system architecture combines the latest technologies supporting multiple GPU form factors, CPU choices, storage, and networking options optimized together to deliver uniquely-configured and highly scalable systems. Systems can be optimized for each customer’s specific Artificial Intelligence (AI), Machine Learning (ML), and High-Performance Computing (HPC) applications. Organizations worldwide are demanding new options for their next generation of computing environments, which have the thermal headroom for the next generation of CPUs and GPUs.

“Supermicro’s Universal GPU Server is a breakthrough for our industry and data center infrastructure,” said Charles Liang, president, and CEO, Supermicro. “With a single powerful, modular, and future-proof platform, we have changed the ground rules for how CTOs and IT administrators can plan for new deployments. This is a flexible and revolutionary system design that is simply the best available and will enable fast deployments at scale.”

Initially, the Universal GPU platform will support systems that contain the 3rd Gen AMD EPYC™ 7003 processors with either the MI250 GPUs or the NVIDIA A100 Tensor Core 4-GPU, and the 3rd Gen Intel Xeon Scalable processors with built-in AI accelerators and the NVIDIA A100 Tensor Core 4-GPU. These systems are designed with an improved thermal capacity to accommodate up to 700W GPUs.

The Supermicro Universal GPU platform is designed to work with a wide range of GPUs based on an open standards design. By adhering to an agreed upon set of hardware design standards, such as Universal Baseboard (UBB) and OCP Accelerator Modules (OAM), as well as PCI-E and platform-specific interfaces, IT administrators can choose the GPU architecture best suited for their HPC or AI workloads. This will meet the demanding requirements of many enterprises and will simplify the installation, testing, production, and upgrades of GPU solutions. In addition, IT administrators will be able to easily choose the right combination of CPUs and GPUs to create the most optimal system for their users.

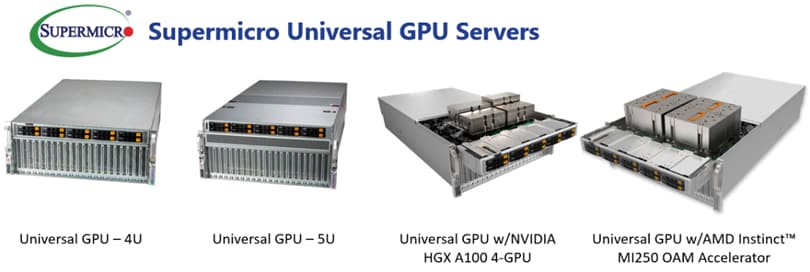

The 4U or 5U Universal GPU server will be available for accelerators that use the UBB standard, as well as PCI-E 4.0, and soon PCI-E 5.0. In addition, 32 DIMM slots and a wide range of storage and networking options are available, which can also be connected using the PCI-E standard. The Supermicro Universal GPU server can accommodate GPUs using baseboards in the SXM or OAM form factors that utilize very high-speed GPU-to-GPU interconnects such as NVIDIA NVLink or the AMD xGMI Infinity fabric, or directly connect GPUs via a PCI-E slot. All major current CPU and GPU platforms will be supported, giving customers choices that match their exact workloads.

The server is designed for maximum airflow and accommodates current and future CPUs and GPUs where the highest TDP CPUs and GPUs are required for maximum application performance. Liquid cooling options (direct to chip) are available for the Supermicro Universal GPU server as CPUs and GPUs require increased cooling solutions. In addition, with its modular design, specific subsystems of this server can be replaced or upgraded, extending the service life of the overall system and reducing the E-waste generated by complete replacement with every new CPU or GPU technology generation.

Supporting Quotes

“The NVIDIA A100 Tensor Core GPU accelerates all AI applications and over 2,700 HPC applications,” said Paresh Kharya, senior director of product management for data center computing, NVIDIA. “Supermicro’s new server platform integrates the NVIDIA A100 to offer enterprises a powerful system that can provide exceptional performance and productivity for a wide range of workloads including HPC, AI inferencing, training, and machine learning.”

“AMD values our close relationship with Supermicro. We are eagerly looking forward to the Supermicro Universal GPU systems, which will be an ideal platform to demonstrate our advanced AMD EPYC CPU and AMD Instinct GPU innovations that address the needs of the HPC industry and the demand for compute-accelerated data center workloads.” – Brad McCredie, corporate vice president, Data Center GPU and Accelerated Processing, AMD

Additional information on the Universal GPU can be found online as well as a webinar scheduled for April 21, 2022, at 10:00 am PT.