Supermicro最先端AI対応インフラソリューションで、AIの真の可能性を解き放ちましょう。大規模トレーニングからインテリジェントエッジ推論まで、当社のターンキーリファレンスデザインがAI導入を効率化し加速させます。最適なパフォーマンスと拡張性でワークロードを強化しながら、コストを最適化し環境への影響を最小限に抑えます。Supermicro多様なAIワークロード最適化ソリューションで可能性の世界を発見し、ビジネスのあらゆる側面を加速させましょう。

大規模AIトレーニングと推論

大規模言語モデル、AI生成学習、自律走行、ロボット工学

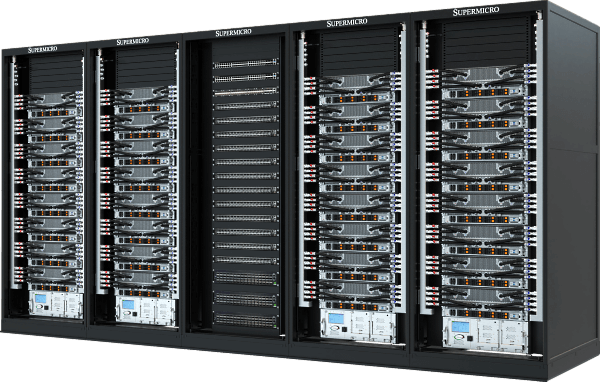

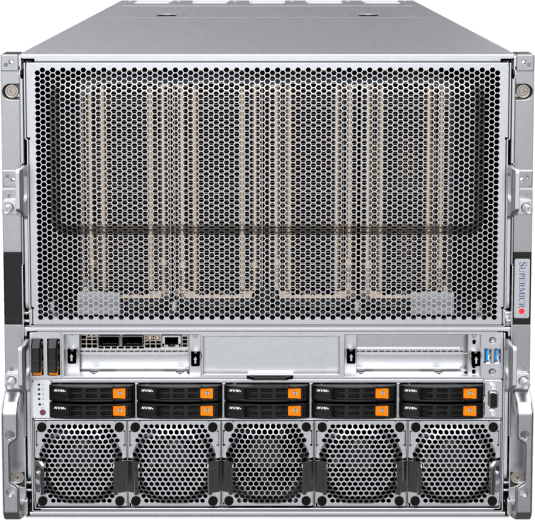

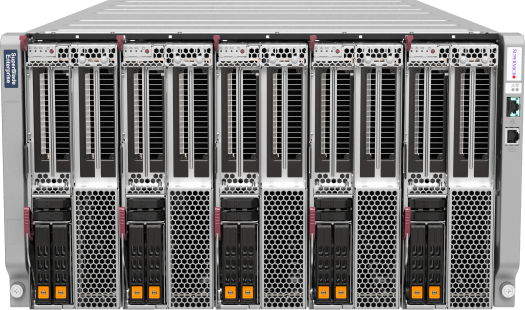

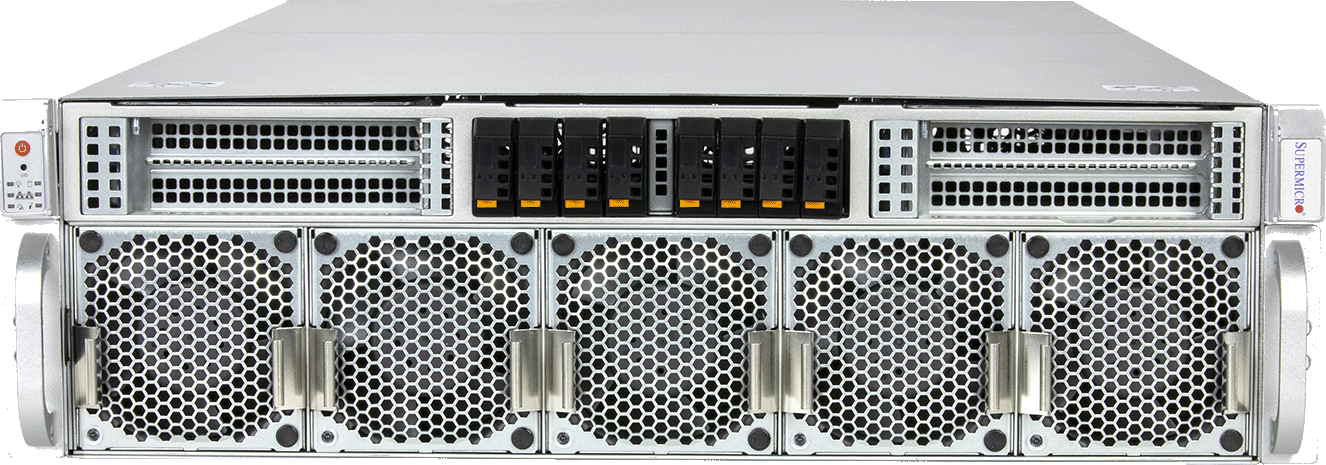

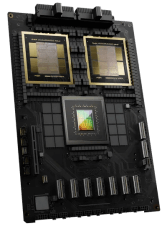

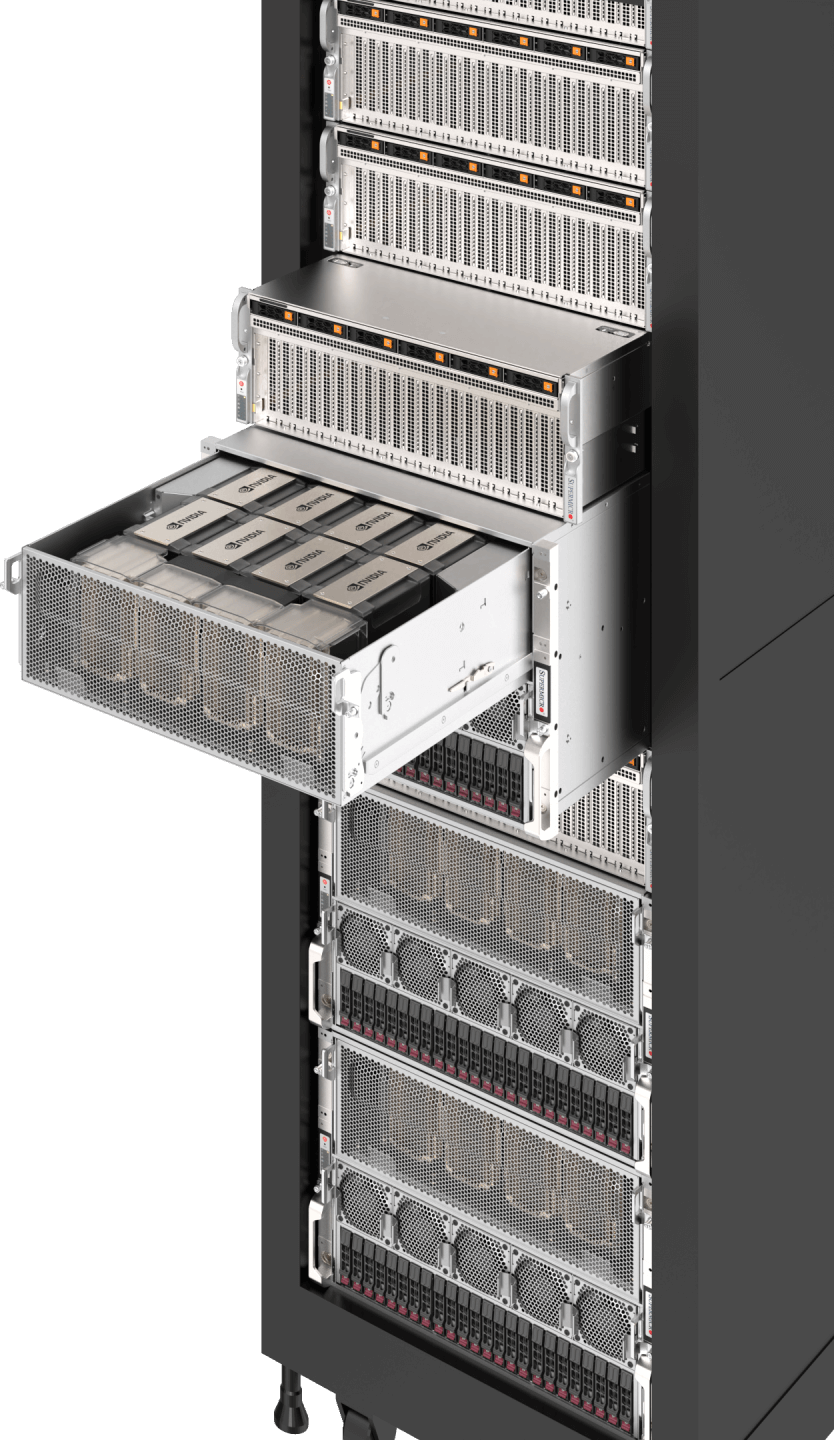

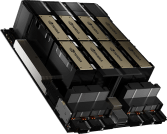

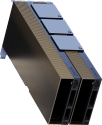

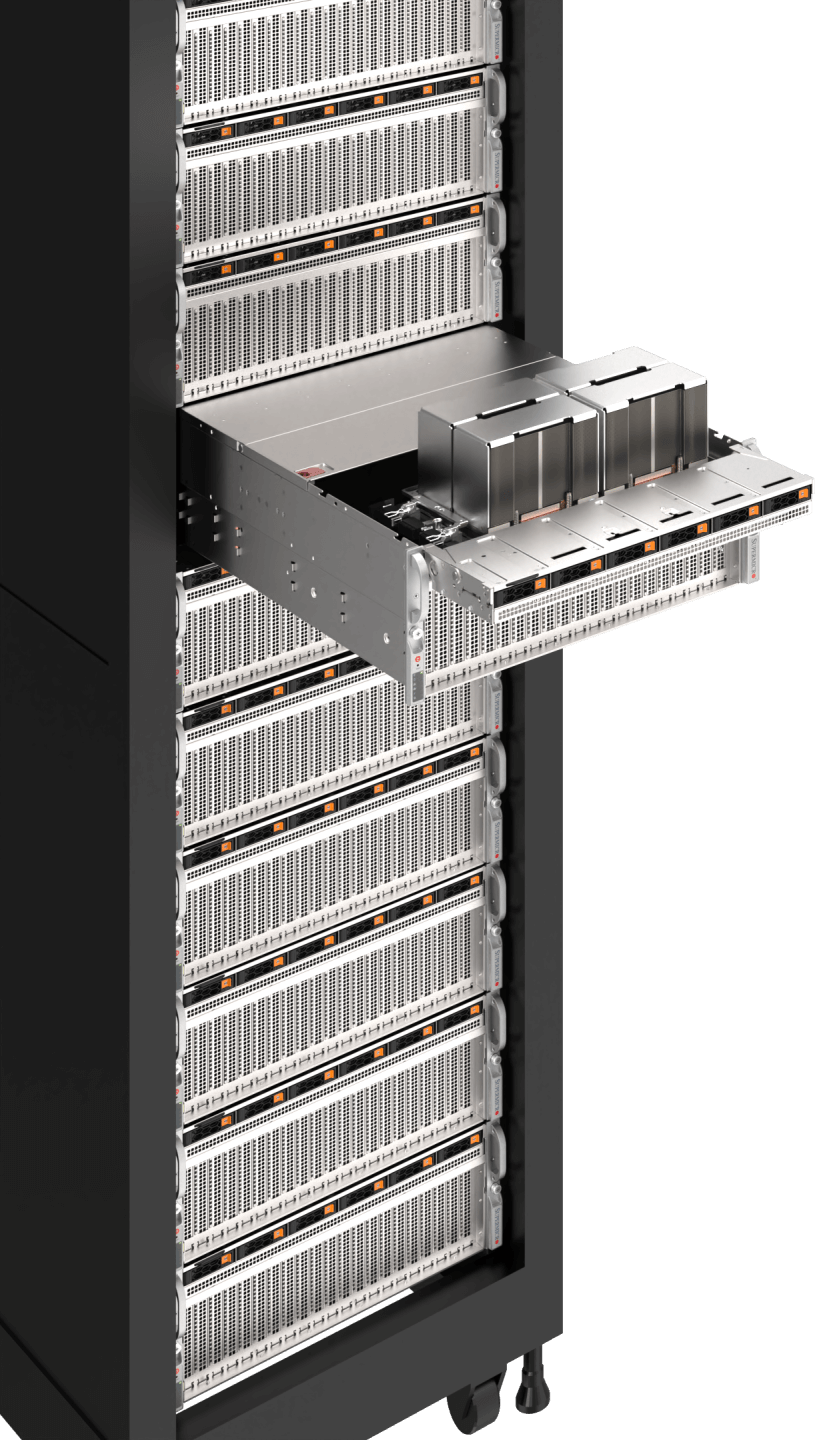

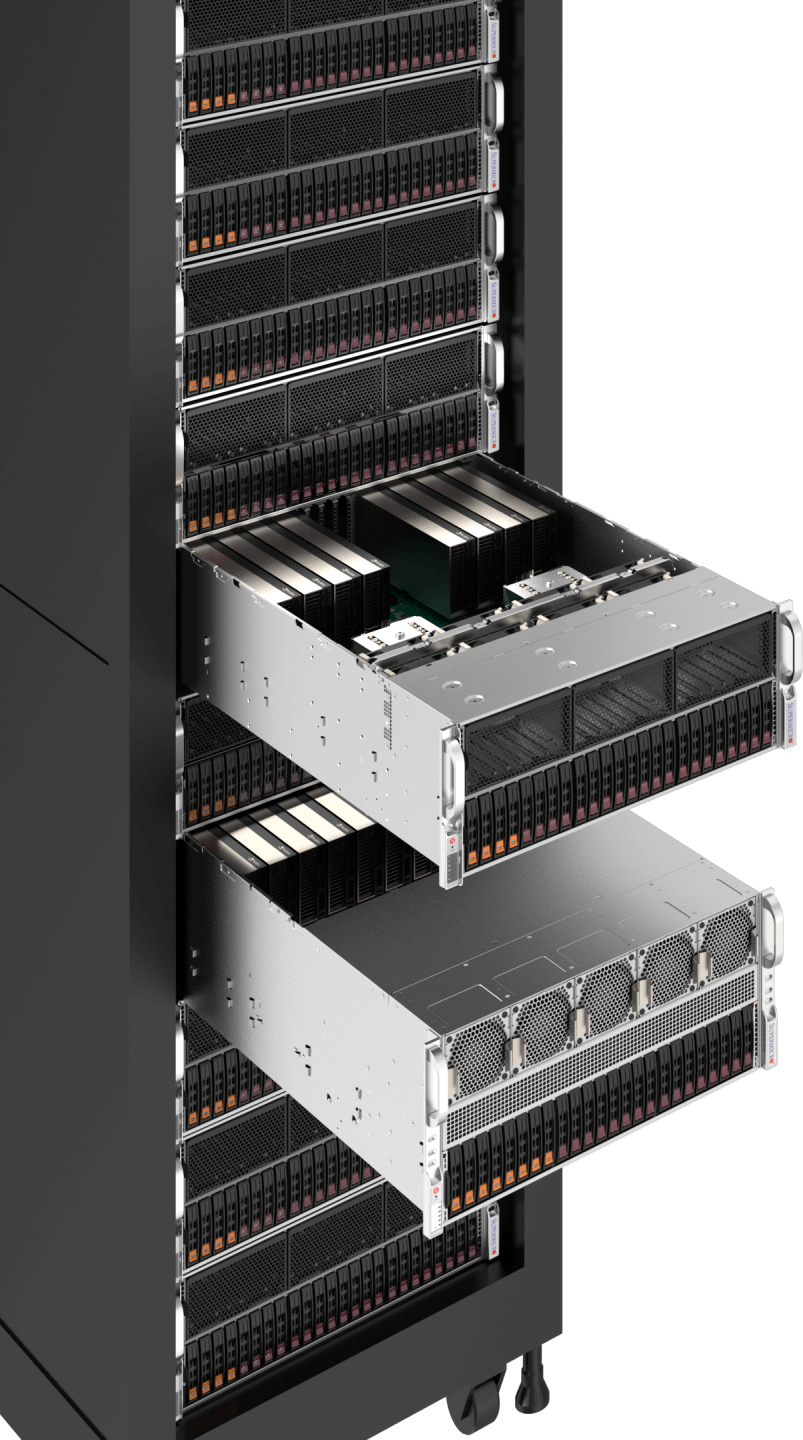

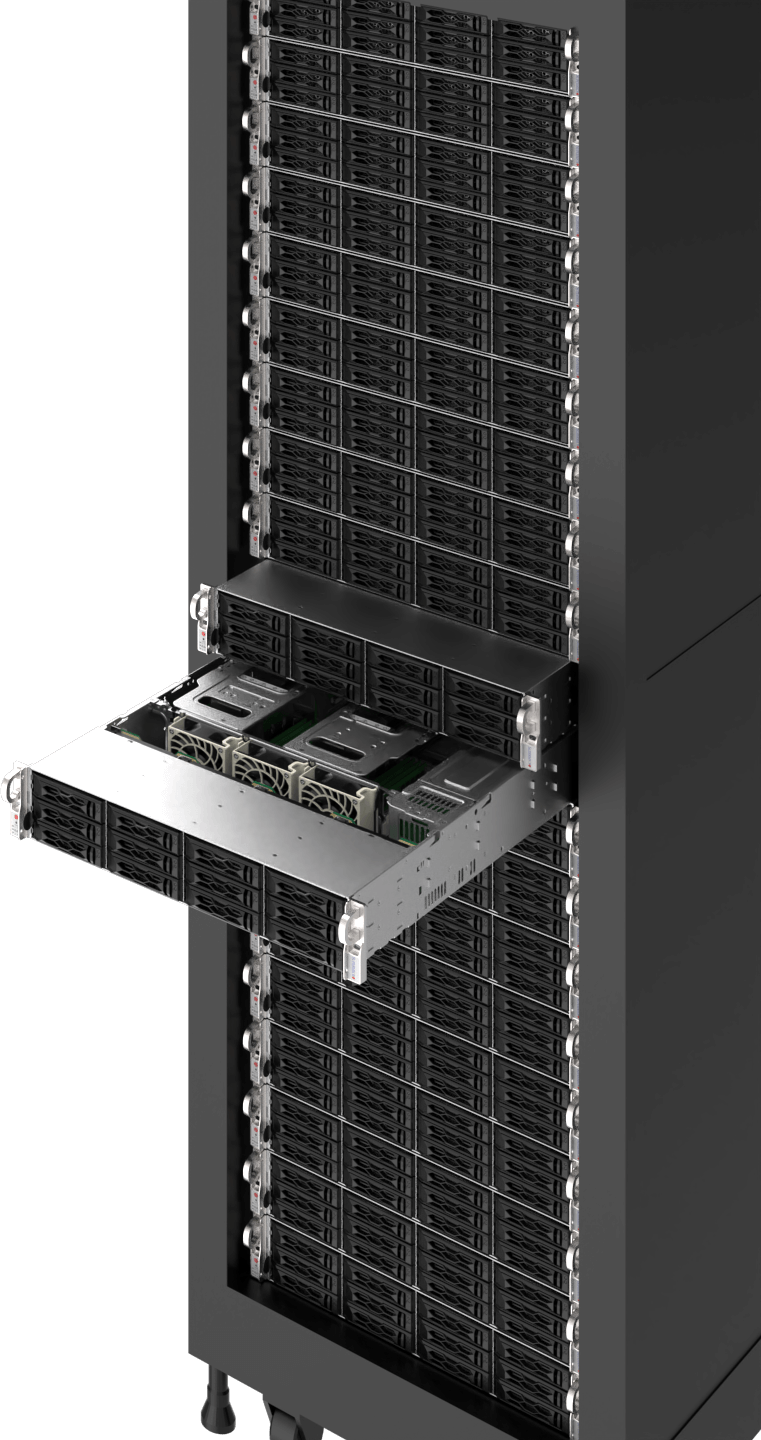

大規模なAIトレーニングには、GPUの並列コンピューティング能力を最大化し、膨大なデータセットでトレーニングされる数十億、数兆のAIモデルパラメータを処理するための最先端技術が必要です。NVIDIAのHGX™ B200およびGB200 NVL72と、最大1.8TB/秒の帯域幅を持つ最速のNVLink®およびNVSwitch® GPU-GPUインターコネクト、およびノードクラスタリングのための各GPUへの最速の1:1ネットワーキングを活用することで、これらのシステムは、大規模な言語モデルをゼロからトレーニングし、数百万人の同時ユーザーに提供するために最適化されています。高速AIデータ・パイプラインのためのオールフラッシュNVMeでスタックを完成させ、液体冷却オプションを備えた完全一体型ラックを提供することで、迅速な導入とスムーズなAIトレーニング体験を保証します。

ワークロードサイズ

- エクストララージ

- 大型

- ミディアム

- ストレージ

リソース

HPC/AI

工学シミュレーション、科学研究、ゲノム解読、創薬

科学者、研究者、エンジニアの発見までの時間を短縮し、より多くのHPCワークロードが機械学習アルゴリズムとGPU加速並列コンピューティングを増強して、より高速な結果を達成しています。世界最速のスーパーコンピューティング・クラスターの多くが、GPUとAIのパワーを活用しています。

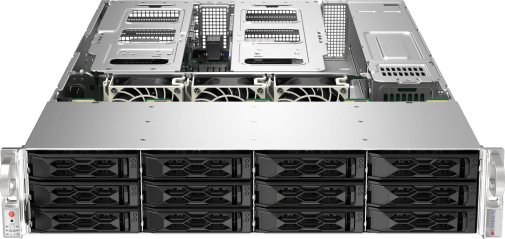

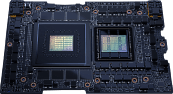

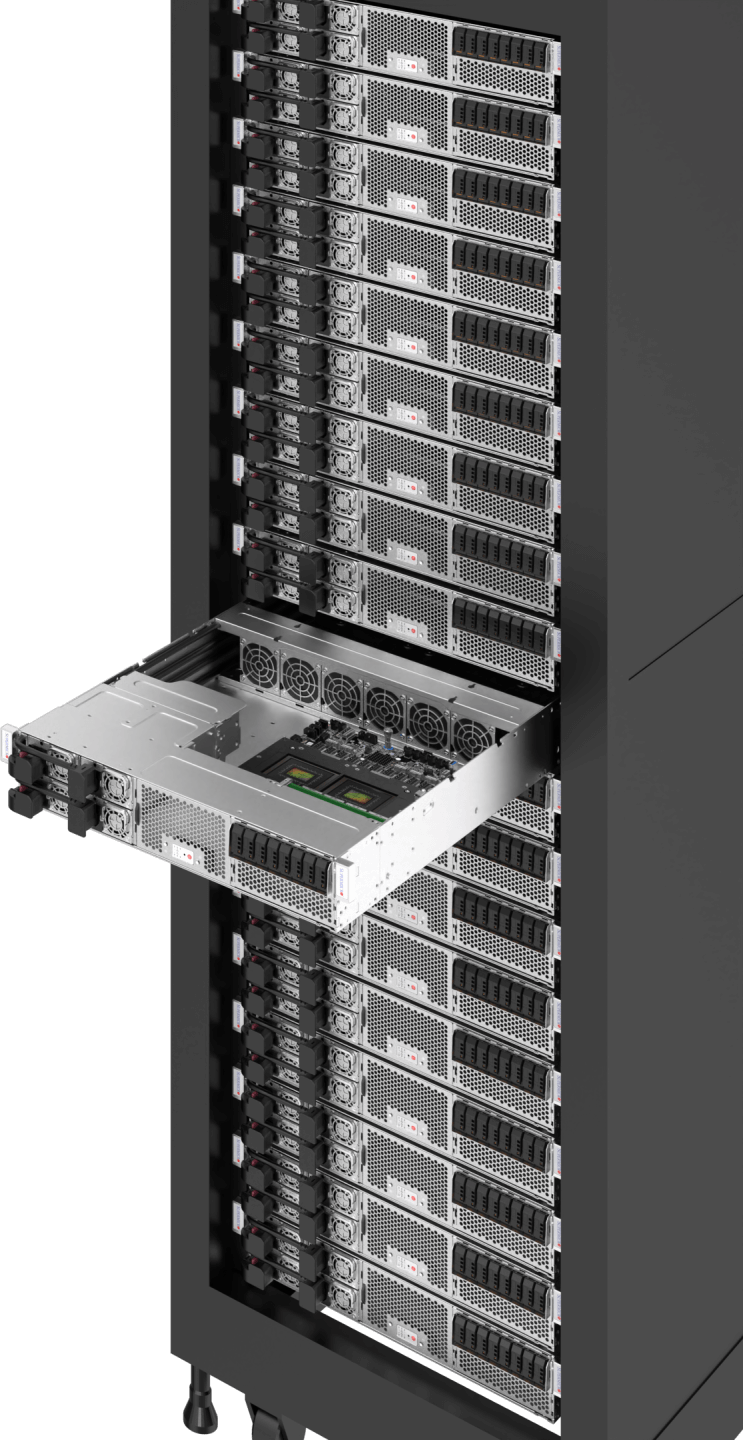

HPCワークロードでは通常、膨大なデータセットと高精度要件を伴うデータ集約型のシミュレーションおよび解析が必要となります。NVIDIAのH100/H200などのGPUは、GPUあたり60テラフロップスを実現する前例のない倍精度性能を提供します。また、Supermicro高度に柔軟なHPCプラットフォームは、ラックスケール統合と液体冷却を備えた様々な高密度フォームファクターにおいて、高いGPU数とCPU数を可能にします。

ワークロードサイズ

- 大型

- ミディアム

リソース

エンタープライズAIの推論とトレーニング

AI生成推論、AI対応サービス/アプリケーション、チャットボット、レコメンダーシステム、業務自動化

ジェネレーティブAIの台頭は、ハイテクから銀行、メディアまで、さまざまな業界にとって次のフロンティアとして認識されています。イノベーションを生み出し、生産性を大幅に向上させ、業務を合理化し、データに基づいた意思決定を行い、顧客体験を向上させる源として、AIの導入競争が始まっています。

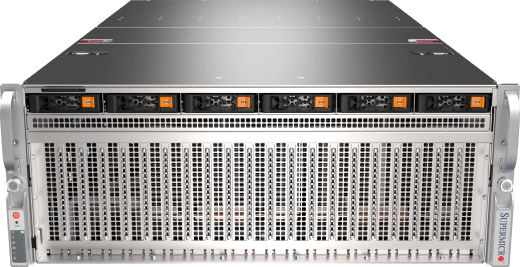

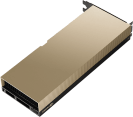

AIを活用したアプリケーションやビジネスモデル、カスタマーサービス向けの知能化された人間のようなチャットボット、コード生成やコンテンツ作成を共に行うAIなど、企業はオープンなフレームワークやライブラリ、事前学習済みAIモデルを活用し、独自のデータセットを用いて特定のユースケースに合わせて微調整することが可能です。 企業がAIインフラを導入するにあたり、Supermicro多様なGPU最適化システムは、オープンなモジュラーアーキテクチャ、ベンダーの柔軟性、そして急速に進化する技術に対応した容易な導入・アップグレードパスを提供します。

ワークロードサイズ

- エクストララージ

- 大型

- ミディアム

リソース

ビジュアライゼーション&デザイン

リアルタイムコラボレーション、3Dデザイン、ゲーム開発

最新のGPUによる3DグラフィックスとAI対応アプリケーションの忠実度の向上は、産業界のデジタル化を加速させ、製品開発・設計プロセス、製造、コンテンツ制作を、現実に忠実な3Dシミュレーションによって変革し、新たな品質の高さ、機会コストのない無限の反復、市場投入までの時間の短縮を実現します。

Supermicro完全統合ソリューションにより、大規模な仮想制作インフラを構築し、産業のデジタル化を加速いたします。これには、4U/5U 8-10 GPUシステム、NVIDIA Omniverse Enterprise向けに最適化されたユニバーサルシーン記述(USD)コネクタを備えたNVIDIAOVX™リファレンスアーキテクチャ、ならびにNVIDIA認定のラックマウントサーバーおよびマルチGPUワークステーションが含まれます。

ワークロードサイズ

- 大型

- ミディアム

リソース

コンテンツ配信と仮想化

コンテンツ・デリバリー・ネットワーク(CDN)、トランスコーディング、圧縮、クラウドゲーム/ストリーミング

動画配信ワークロードは、現在のインターネットトラフィックの大部分を占め続けています。ストリーミング・サービス・プロバイダーが4Kや8Kのコンテンツを提供したり、より高いリフレッシュ・レートでクラウド・ゲーミングを行うことが増えているため、メディア・エンジンによるGPUアクセラレーションは、AV1エンコーディングやデコーディングなどの最新技術により、必要なデータ量を削減しながら、ストリーミング・パイプラインのスループット性能を数倍に高めるために不可欠です。

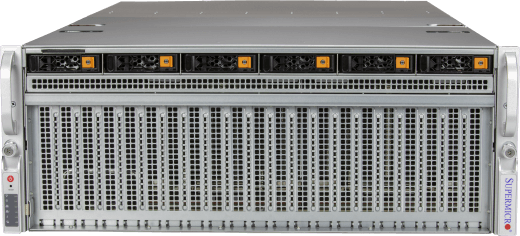

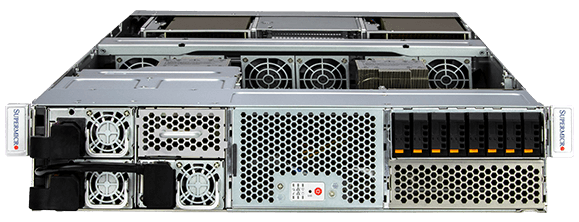

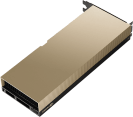

SupermicroマルチノードおよびマルチGPUシステム(例:2U 4ノードBigTwin®システム)Supermicro、現代の映像配信における厳しい要件を満たしております。各ノードはNVIDIA L4 GPUをサポートし、豊富なPCIe Gen5ストレージとネットワーク速度を備えることで、コンテンツ配信ネットワークにおける要求の厳しいデータパイプラインを駆動する能力を有しております。

ワークロードサイズ

- 大型

- ミディアム

- 小さい

リソース

エッジAI

エッジビデオトランスコーディング、エッジ推論、エッジトレーニング

業界を問わず、従業員や顧客が都市、工場、小売店、病院などのエッジロケーションで関わる企業は、エッジでのAI導入への投資を増やしています。エッジでデータを処理し、AIやMLアルゴリズムを活用することで、企業は帯域幅とレイテンシの制限を克服し、タイムリーな意思決定、予測ケア、パーソナライズされたサービス、合理化された事業運営のためのリアルタイム分析を可能にします。

専用設計で環境に最適化されたSupermicro 、様々なコンパクトなフォームファクターを備え、低遅延・オープンアーキテクチャに必要な性能を提供します。事前統合されたコンポーネント、多様なハードウェアおよびソフトウェアスタックとの互換性、複雑なエッジ展開に必要なプライバシーとセキュリティ機能セットを標準装備しております。

ワークロードサイズ

- エクストララージ

- 大型

- ミディアム

- 小さい

リソース

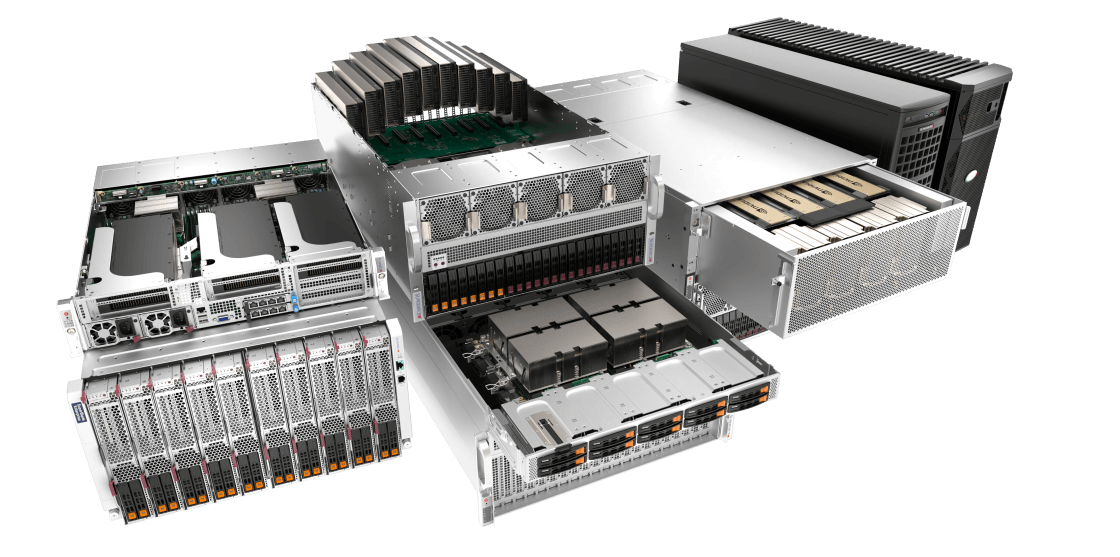

AI対応システムの幅広いポートフォリオ

COMPUTEX 2024 CEO基調講演