Supermicro AMD ソリューション

GenAIをパイロット段階から本番環境へ拡張するには、ラック単位で電力、冷却、性能のバランスが取れたデータセンター対応インフラが必要です。AMD EPYC™プロセッサーAMD Instinct™MI325Xアクセラレータを搭載Supermicro 、高密度GPU容量、ultraスループット、低遅延を実現し、トレーニングと推論の両方に対応します。高度な液体冷却、マルチラック統合、高帯域幅ネットワークにより、企業は効率を最大化し、導入リスクを低減し、過酷な実環境におけるAIワークロードの将来性を確保できます。

GenAIワークロードに最適化されたコンピュート

EPYC Supermicro 、大規模なAIモデルのトレーニングおよび推論をサポートするために必要な高いメモリ帯域幅、コア密度、およびPCIeレーンを提供します。

大規模なターンキーAIインフラ

ラックレベルの液冷システムは、導入の複雑さを軽減すると同時に、概念実証から完全な本番環境への効率的な拡張を可能にします。

検証済みのGenAIソリューションスタック

事前統合されたハードウェアおよびソフトウェアスタック(AMD 、PyTorch、Kubernetesを含む)により、価値創出までの時間を短縮し、MLOpsワークフローを効率化します。

サステナビリティとパフォーマンスの融合

Supermicro省エネシステムは、AMD電力最適化アーキテクチャと組み合わせることで、総所有コストの削減に貢献し、持続可能なAI運用をサポートいたします。

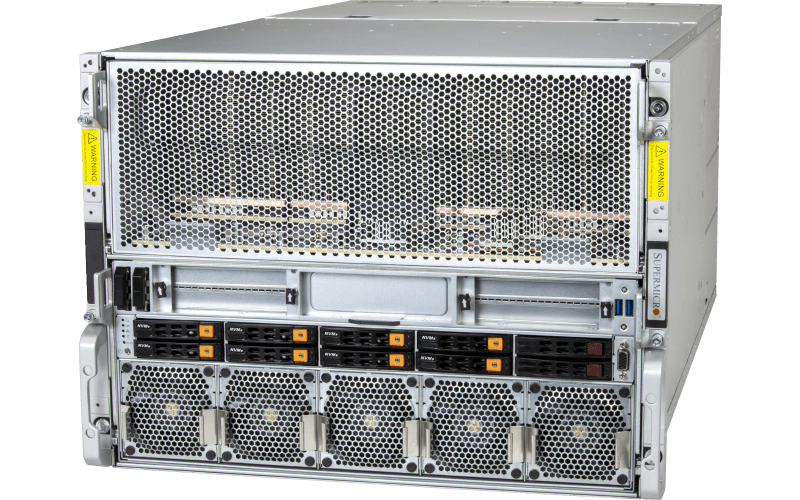

注目商品

2UHyper A+サーバー

AS -2126HS-TN

最大24基のホットスワップ2.5インチNVMe/SAS/SATAベイと4基のPCIe 5.0 x16スロット+1基のPCIe 5.0 x16 AIOMスロットを備えた2UHyper

関連資料