あなたのNVIDIA Blackwellの旅はここから始まります。

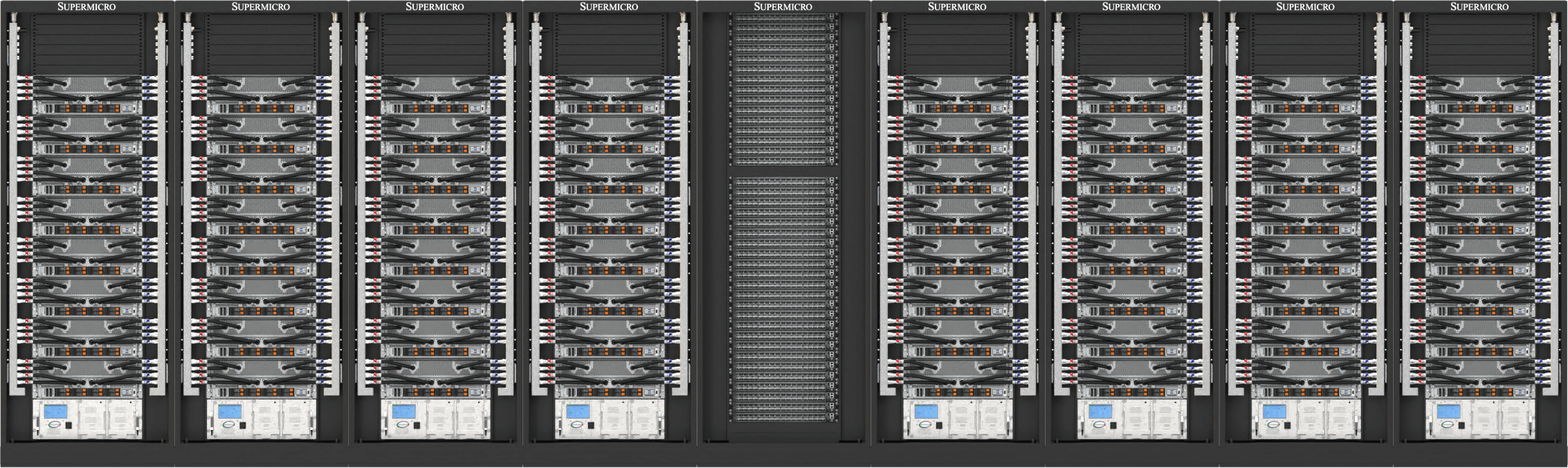

AIの変革の瞬間が到来しています。進化するスケーリング則とAI推論の台頭により、データセンターの能力は新たな限界値へと押し上げられています。Supermicro の最新 NVIDIA Blackwell 搭載ソリューションは、NVIDIAとの緊密な連携によって開発され、次世代の空冷および液冷アーキテクチャにより、かつてないほどの演算性能、搭載密度、効率性を実現しています。さらに、迅速な導入が可能なAI向けデータセンター・ビルディング・ブロック・ソリューションにより、Supermicro はNVIDIA Blackwell 活用に向けた最高のパートナーであ り、AIイノベーションを加速させる持続可能な最先端ソリューションを提供します。

エンド・ツー・エンドのAIデータセンター・ビルディング・ブロック・ソリューションの強み

複数のCPUオプションを備えた幅広い空冷および液冷システム、完全なデータセンター管理ソフトウェアスイート、完全なネットワーク、ケーブル配線、クラスタレベルのL12検証を含むターンキーラックレベルの統合、グローバルな配送、サポート、サービス。

- 豊富な経験

- Supermicro、世界最大規模の液体冷却式AIデータセンターの導入を支えております。

- 柔軟なサービス

- 空冷または液冷、GPU最適化、複数のシステムおよびラックフォームファクター、CPU、ストレージ、ネットワークオプションなど、お客様のニーズに合わせて最適化します。

- 液冷のパイオニア

- AI革命を支える、実証済みの拡張可能なプラグアンドプレイ液冷ソリューション。NVIDIA Blackwellアーキテクチャ専用に設計されています。

- 短期間での導入

- グローバルな生産能力、世界クラスの導入専門知識、オンサイトサービスにより、短期間でのAI導入をサポートします。

最もコンパクトなハイパースケールAIプラットフォーム

NVIDIA HGX™ B300システムは、OCP ORV3設計向けに最適化されており、1ラックあたり最大144基のGPUを搭載可能です。

Supermicro液体冷却式SupermicroHGX B300Supermicro、ハイパースケール展開向けに比類のないGPU密度を実現します。OCP ORV3仕様に準拠し、先進的なDLC-2技術を採用したコンパクトな8GPUノードは21インチラックに収まり、1ラックあたり最大18ノード、合計144基のGPUを搭載可能です。 ブラインドメイト方式のマニホールド接続とモジュラーGPU/CPUトレイ構造を採用し、各B300 GPUを最大1,100W TDPで安定動作させながら、ラック占有面積・消費電力・冷却コストを大幅に削減します。卓越した保守性と最大性能密度を要求されるAIファクトリーに最適です。

GPUあたり288 GBのHBM3e

2-OU 液体冷却システム

NVIDIA HGX B300 8GPU用

標準化されたORV3ラック内に最大144基のNVIDIA BlackwellUltra

AI推論のためのUltra

NVIDIA HGX™ B300のための最先端の空冷および液冷アーキテクチャ

SupermicroのNVIDIA HGX プラットフォームは、世界最大級のAIクラスターの多くを支える基盤となっており、今日の革新的なAIアプリケーションに不可欠な膨大な演算能力を提供しています。最新の NVIDIA Blackwell Ultra を搭載する8U 空冷システムは、最大 2.3TB の HBM3e メモリーを搭載する、8 基の1100W TDP NVIDIA HGX B300 GPU の性能を最大限に引き出すように設計されています。前面の8つのOSFP ポートは、800 Gb/s の NVIDIA ConnectX®-8 SuperNICを統合し、NVIDIA Quantum-X800 InfiniBandまたは NVIDIA Spectrum-XTM Ethernet コンピューティングファブリックとのプラグアンドプレイによる導入を可能にします。新しい 4U 液冷システムは、Supermicro の DLC-2テクノロジーを採用しており、最大98%の熱回収を実現し、データセンターの電力消費量を最大40%削減することが可能です。DCBBSとSupermicro の専門知識を持ったオンサイト導入支援の組み合わせによって、液冷テクノロジー、ネットワークトポロジーと配線、電力供給、熱管理を網羅したトータルソリューションを提供し、AIファクトリーのオンライン化を加速します。

4U水冷式または8U空冷式システム

NVIDIA HGX B300 8GPU用

フロントI/O搭載の液体冷却システム(NVIDIAConnectX-8800 Gb/s ネットワーク機能を統合)

NVIDIAConnectX-8ネットワーキングを統合したNVIDIA BlackwellUltra HGX B300 8GPU用フロントI/O空冷システム

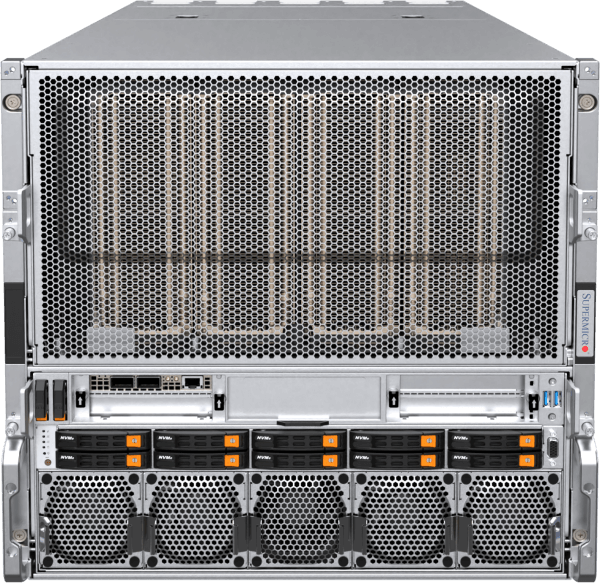

1ラックでエクサスケール・コンピューターを実現

NVIDIA GB300 NVL72用エンドツーエンド液冷ソリューション

Supermicro GB300 NVL72 は、基礎モデルのトレーニングから大規模推論処理に至るAI計算需要に対応します。高いAI性能とSupermicroダイレクト液体冷却技術を組み合わせ、最大級の計算密度と効率を実現します。NVIDIA BlackwellUltra基盤とし、1ラックに72基のNVIDIA B300 GPU(各288GB HBM3eメモリ搭載)を統合します。 1.8TB/sのNVLink相互接続を備えたGB300 NVL72は、単一ノードでエクサスケールスーパーコンピュータとして動作します。アップグレードされたネットワークは、コンピューティングファブリック全体の性能を倍増させ、800Gb/sの速度をサポートします。Supermicro製造能力とエンドツーエンドサービスにより、液体冷却式AIファクトリーの導入が加速され、GB300 NVL72クラスターの市場投入までの時間を短縮します。

NVIDIA GB300 NVL72およびGB200 NVL72

NVIDIA GB300/GB200 Grace™ Blackwell Superchip用

72 NVIDIA BlackwellUltra GPUを1つのNVIDIA NVLinkドメインに。Ultra パフォーマンスとスケーラビリティ

1つのNVIDIA NVLinkドメインに72個のNVIDIA Blackwell GPU。AIコンピューティングアーキテクチャの頂点。

進化した空冷システム

NVIDIA HGX B200 8GPU用に再設計・最適化されたベストセラー空冷システム

新型の空冷式NVIDIA HGX B200 8-GPUシステムは、強化された冷却アーキテクチャ、CPU・メモリ・ストレージ・ネットワークの高構成性、前面または背面からのサービス性を向上させた特長を備えております。 最大4台の新型8U/10U空冷システムをラックに設置・完全統合することが可能で、前世代と同等の密度を実現しながら、最大15倍の推論性能と3倍のトレーニング性能を提供します。 すべてのSupermicro HGX B200 システムは、1:1 の GPU 対 NIC 比率を備え、NVIDIABlueField®-3または NVIDIAConnectX®-7をサポートし、高性能コンピューティングファブリック全体でのスケーリングを実現します。

8UフロントI/Oまたは10UリアI/O空冷システム

NVIDIA HGX B2008GPU用

システム・メモリ構成の柔軟性とコールド・アイル・サービス性を強化したフロントI/O空冷システム

大規模言語モデルのトレーニングや大量の推論に対応するリアI/O空冷設計

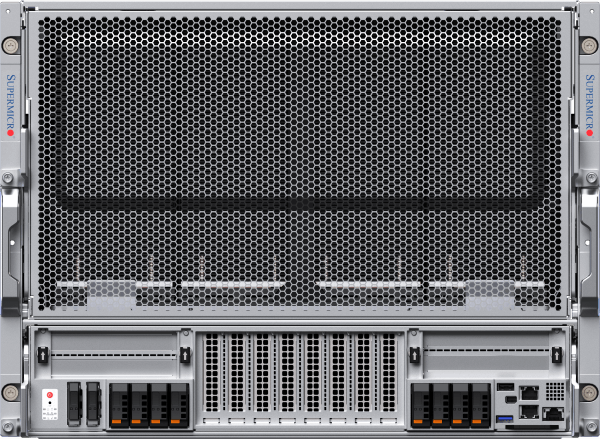

次世代液冷システム

最大96基のNVIDIA HGX™ B200 GPUを1つのラックに搭載し、最高のスケーラビリティと効率性を実現

新開発のフロントI/O搭載、液体冷却方式を採用した4U NVIDIA HGX B2008-GPUシステムは、Supermicroテクノロジーを搭載しております。ダイレクト液体冷却により、CPU、GPU、PCIeスイッチ、DIMM、VRM、PSUなどのサーバーコンポーネントから発生する熱の最大92%を捕捉。これにより、データセンターの電力消費を最大40%削減し、騒音レベルは50dBまで低減することが可能となりました。 この新アーキテクチャは、NVIDIA HGX H100/H2008-GPUシステム向けに設計された前世代モデルをさらに効率化・保守性を向上させております。 42U、48U、52U構成で提供される本ラックスケール設計では、新開発の垂直冷却剤分配マニホールド(CDM)を採用したことで、水平マニホールドが貴重なラックスペースを占有しなくなりました。これにより、42Uラックに64基のNVIDIA Blackwell GPUを搭載した8システム、52Uラックには最大96基のNVIDIA GPUを搭載した12システムを収容することが可能となります。

4UフロントI/OまたはリアI/O液冷システム

NVIDIA HGX B2008GPU用

フロントI/O DLC-2液冷システム、データセンターの電力を最大40%節約、ノイズレベルは50dBまで低減

最大の計算密度とパフォーマンスを実現するために設計されたリアI/O液冷システム

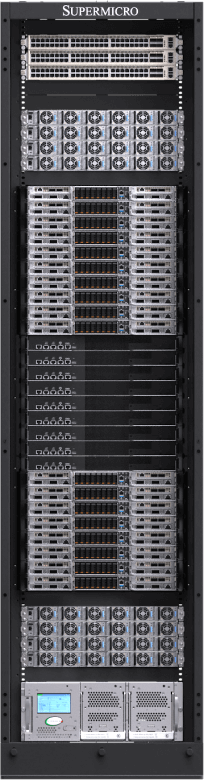

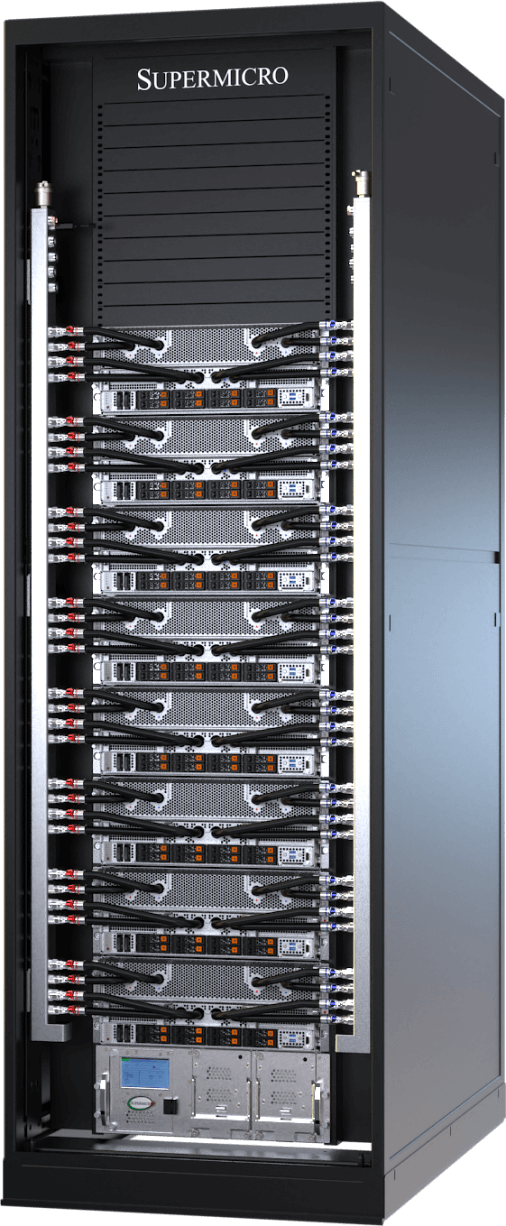

迅速な導入が可能なNVIDIA Blackwellプラグアンドプレイスケーラブルユニット

空冷または液冷データセンター用に42U、48U、または52Uのラック構成で利用できる新しいSuperClusterは、ラック内中段にNVIDIA Quantum InfiniBandまたはNVIDIA Spectrum™ネットワーキングを組み込んでおり、液冷SuperClusterは、42U/48Uの5ラックで、ノンブロッキングの256GPUのスケーラブルユニット を提供し、最先端のAIデータセンター展開向けに52Uの9ラックで、拡張768GPUのスケーラブルユニットを提供します。Supermicroはまた、大規模展開向けのインローCDUオプションや、設備用水を必要としないLiquid-to-Airのラックソリューションも提供しています。空冷SuperClusterの設計は、実績のある前世代のアーキテクチャを継承し、48Uの9ラックで256GPUのスケーラブルユニットを提供します。

NVIDIA Blackwellのためのエンドツーエンドのデータセンター・ビルディング・ブロック・ソリューションと展開サービス

Supermicroは、グローバルな製造拠点を持つ包括的なワンストップ・ソリューションプロバイダーとして、データセンターレベルのソリューション設計、液冷技術、スイッチング、ケーブル配線、データセンター管理ソフトウェア一式、L11およびL12ソリューションの検証、現場での設置、専門的なサポートとサービスを提供します。サンノゼ、ヨーロッパ、アジアに製造拠点を持つSupermicroは、液冷または空冷ラックシステムの圧倒的な製造能力を提供し、タイムリーな納品、総所有コスト(TCO)の削減、一貫した品質を保証します。

NVIDIA Quantum InfiniBandまたはNVIDIA Spectrum™ネットワーキングでラック内中段に最適化配置されたSupermicroのNVIDIA Blackwellソリューションは、最高のインフラストラクチャのスケーリングとGPUクラスタリングを実現し、5ラックでノンブロッキングの256GPUスケーラブルユニット、または9ラックで拡張768GPUスケーラブルユニットを提供します。NVIDIA Enterpriseソフトウェアをネイティブにサポートするこのアーキテクチャは、Supermicroの液冷技術と共に世界最大のAIデータセンターに優れた効率性を提供し、展開までの期間を短縮します。

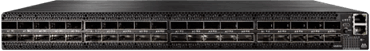

NVIDIA Quantum InfiniBandおよびSpectrum Ethernet

主流のエンタープライズサーバーから高性能スーパーコンピュータまで、NVIDIA Quantum InfiniBandおよびSpectrum™ネットワーキング技術は、最もスケーラブルで高速かつ安全なエンドツーエンドネットワーキングを実現します。

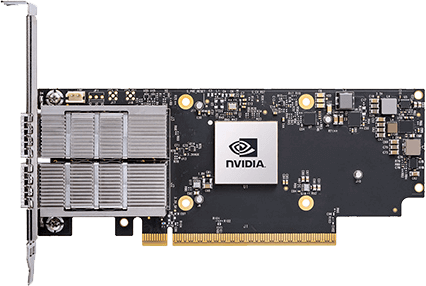

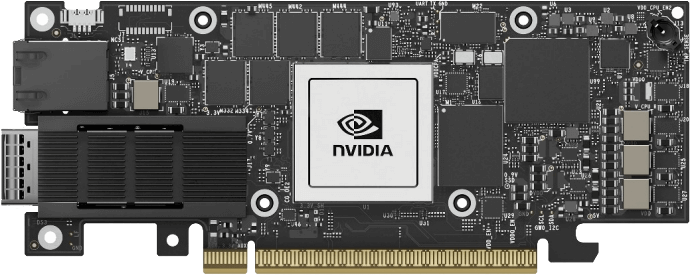

NVIDIA SuperNICs

SupermicroはInfiniBand用のNVIDIA ConnectXとイーサネット用のNVIDIA BlueField-3 SuperNICを採用しています。SupermicroのNVIDIA HGX B200システムはすべて、超並列AIコンピューティングのためのNVIDIA GPUDirect® RDMA (InfiniBand)またはRoCE (イーサネット)を利用できるように、各GPUに1:1のネットワーキングを搭載しています。

NVIDIA AI エンタープライズソフトウェア

NVIDIAアプリケーションフレームワーク、API、SDK、Toolkit、Optimizerへのフルアクセスに加え、AI Blueprint、NVIDIA NIM、RAG、最新の最適化されたAI基盤モデルを展開する機能なども提供されます。NVIDIA AI Enterprise Softwareは、エンタープライズ規模のセキュリティ、サポート、安定性を備えたプロダクショングレードのAIアプリケーションの開発と展開を合理化し、プロトタイプから本番へのスムーズな移行を実現します。